Lo que sabemos de los bombardeos en Venezuela y la imputación de Nicolás Maduro en Estados Unidos

Entre la 1:50 y las primeras horas de la madrugada del 3 de enero, residentes y medios reportaron al menos siete explosiones y movimiento de aeronaves en Caracas y zonas cercanas.

Las detonaciones se escucharon en sectores como La Carlota, Fuerte Tiuna, El Valle, La Vega, El Hatillo, Higuerote y Mamo. En algunos puntos de la capital se registraron cortes de electricidad.

⚠️ Este video no muestra un ataque al Cuartel de la Montaña 4F, sino al Comando General de la Milicia Bolivariana, antiguo Observatorio Gagigal, a 500 m

— Cazadores de Fake News (@cazamosfakenews) January 3, 2026

Confirmamos la estructura impactada mediante geolocalización. También hay usuarios de redes sociales que confirman que el… pic.twitter.com/se7Gm0rAWZ

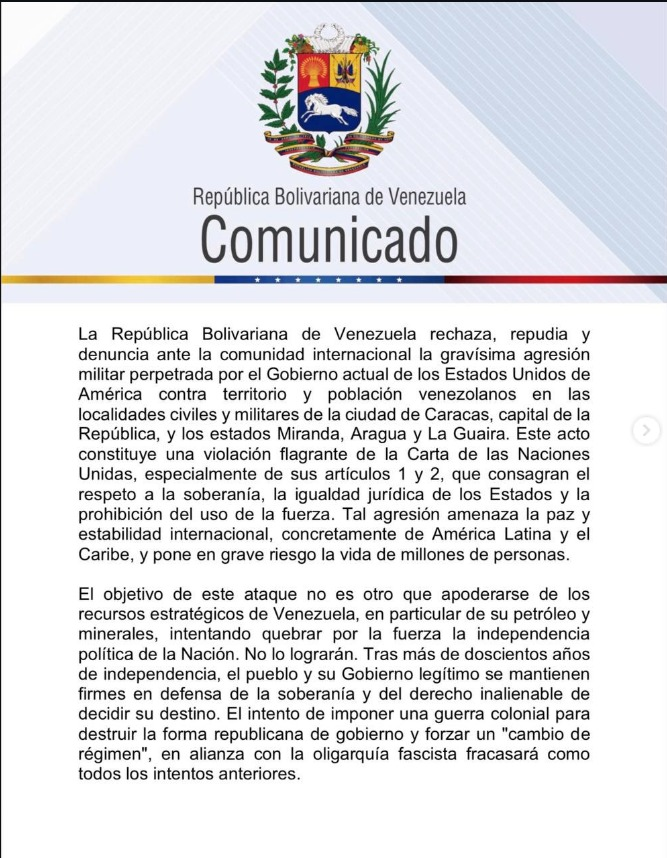

El gobierno venezolano afirmó que los ataques afectaron infraestructura civil y militar en Caracas y en los estados Miranda, Aragua y La Guaira.

¿Qué dijo Estados Unidos?

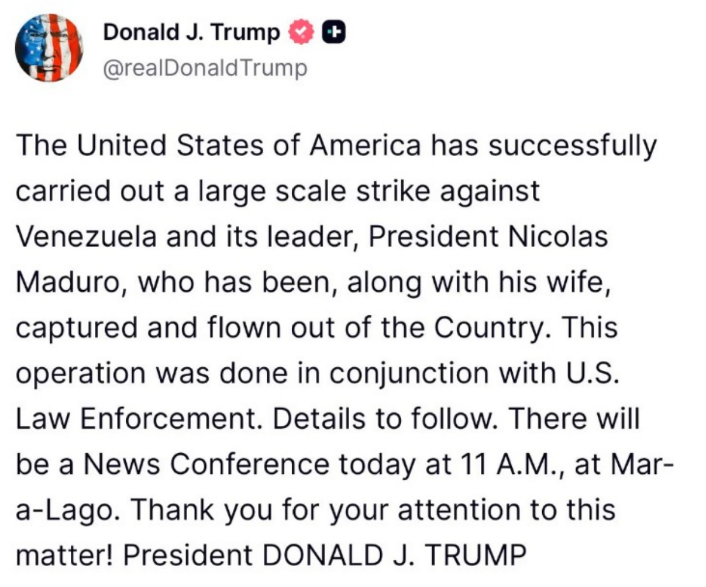

A través de redes sociales, Trump aseguró que Estados Unidos ejecutó una operación militar y que Nicolás Maduro y su esposa fueron capturados y trasladados fuera de Venezuela.

Horas más tarde, la fiscal general de Estados Unidos, Pamela Bondi, informó que Maduro y Cilia Flores fueron imputados en el Distrito Sur de Nueva York.

Según el Departamento de Justicia, Maduro enfrenta cargos por:

- Conspiración de narco-terrorismo

- Conspiración para la importación de cocaína

- Posesión y conspiración para poseer armas de guerra y dispositivos destructivos contra Estados Unidos

Las autoridades estadounidenses sostienen que ambos imputados enfrentarán la justicia en tribunales estadounidenses, aunque no han difundido evidencia pública que confirme su ubicación actual.

Cómo fue la operación militar, según Estados Unidos

De acuerdo con declaraciones oficiales del gobierno estadounidense:

- La operación habría estado a cargo de la Delta Force, una unidad de élite del Ejército de Estados Unidos.

- Fue denominada “Absolute Resolve” y se ejecutó, según el mando militar, a pedido del Departamento de Justicia.

- El jefe del Estado Mayor Conjunto, el general Dan Caine, indicó que participaron alrededor de 150 aeronaves, entre aviones y helicópteros.

- Aviones de combate habrían neutralizado las defensas aéreas venezolanas para permitir el ingreso de helicópteros a Caracas.

- Uno de los helicópteros fue alcanzado por fuego antiaéreo, aunque logró mantenerse operativo.

- La operación habría durado aproximadamente dos horas y 20 minutos.

- Estados Unidos sostiene que se trató de una acción puntual, no de una campaña militar prolongada.

El secretario de Estado, Marco Rubio, afirmó que no están previstas nuevas acciones militares tras la detención de Maduro. Sin embargo, Trump declaró posteriormente que Estados Unidos permanecerá involucrado hasta que, según sus palabras, se produzca una transición ordenada, y advirtió que su país está preparado para una segunda operación si lo considera necesario.

¿Qué respondió el régimen venezolano?

El gobierno de Venezuela calificó los hechos como una agresión militar por parte de Estados Unidos y denunció una violación del derecho internacional.

El ministro de Defensa, Vladimir Padrino López, anunció la activación de planes de defensa nacional, mientras que la vicepresidenta Delcy Rodríguez afirmó desconocer el paradero de Maduro y exigió una prueba de vida.

¿Qué se sabe del proceso judicial contra Maduro?

El proceso judicial contra Nicolás Maduro en Estados Unidos no comienza en enero de 2026. Sus antecedentes se remontan a marzo de 2020, cuando fiscales del Distrito Sur de Nueva York lo acusaron de narcotráfico internacional, identificándolo como uno de los líderes del Cártel de los Soles, una red que, según la acusación, involucra a altos funcionarios del Estado venezolano.

De acuerdo con la Fiscalía estadounidense, Maduro habría participado en la coordinación y protección de envíos de cocaína a gran escala, utilizando estructuras estatales para facilitar el tráfico de drogas hacia Estados Unidos.

El anuncio del 3 de enero de 2026 amplía y agrava esas acusaciones, al incorporar cargos vinculados al narco-terrorismo y al uso de armamento militar, lo que eleva el nivel del caso y las posibles penas.

Sin embargo, hasta ahora:

- No se ha informado públicamente de una audiencia inicial ni de una comparecencia ante un juez federal.

- No se han difundido documentos judiciales accesibles que confirmen el inicio formal del proceso en sede judicial.

- Toda la información disponible proviene de comunicados del Ejecutivo y del Departamento de Justicia de Estados Unidos.

En el sistema judicial estadounidense, una imputación puede existir aunque el acusado no haya sido presentado físicamente ante la corte, por lo que el caso puede estar abierto sin que haya comenzado aún el trámite procesal público.

Cómo queda el poder en Venezuela

El presidente de Estados Unidos, Donald Trump, aseguró que su país asumirá temporalmente el control de Venezuela mientras, según sus palabras, se organiza una “transición ordenada”.

Trump señaló que Estados Unidos “va a manejar el país”, sin precisar bajo qué marco legal, por cuánto tiempo ni quiénes ejercerían funciones de gobierno. Tampoco explicó si se trata de una ocupación formal, un gobierno provisional o algún otro mecanismo.

El mandatario vinculó esta etapa con la industria petrolera venezolana, al afirmar que empresas estadounidenses invertirían en la infraestructura energética y que esos recursos financiarían la recuperación del país.

Hasta ahora, no existe confirmación independiente de que Estados Unidos esté ejerciendo control efectivo sobre Venezuela ni de que se haya producido una transición de poder. El régimen venezolano niega la captura de Nicolás Maduro y mantiene el control institucional del Estado.

Desinformación

«Un vídeo muestra un bombardeo en Fuerte Tiuna, Venezuela».

«Un vídeo muestra un bombardeo en Fuerte Tiuna, Venezuela».

No, este video no muestra un bombardeo en Fuerte Tiana, Venezuela. En realidad, muestra los ataques con misiles iraníes contra Israel durante la guerra de los 12 días, registrada en agosto de 2025.

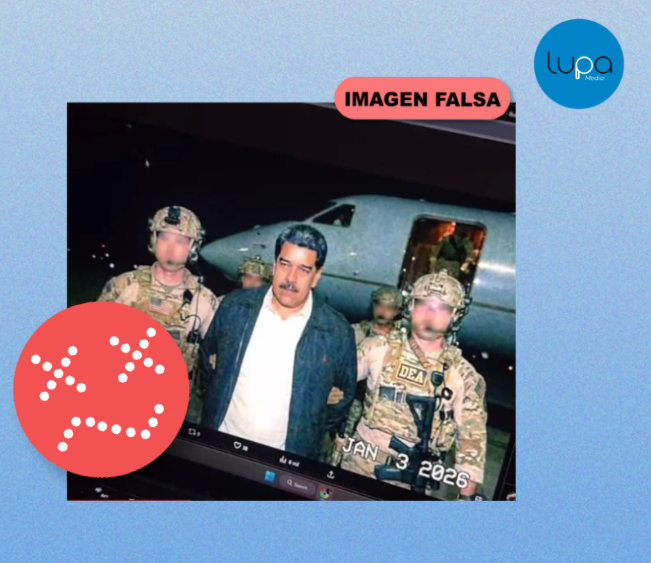

«Está imagen muestra la captura de Nicolás Maduro con militares»

«Está imagen muestra la captura de Nicolás Maduro con militares»

No hay evidencia de que la imagen que circula de Nicolás Maduro capturado sea real. Existen indicios claros de que fue generada con inteligencia artificial. La imagen presenta inconsistencias visuales —como rasgos faciales poco definidos y detalles que no coinciden con fotografías auténticas—, elementos comunes en contenidos creados con IA.

Además, según SynthID de Google, la imagen contiene una marca de agua digital que indica que fue editada o generada, en su mayor parte o en su totalidad, con la inteligencia artificial de Google. Por otro lado, otros medios de verificación, como nuestros colegas de Verificado (de México), ya han catalogado esta imagen como falsa.

«Este vídeo muestra el retiro de las pancartas de Nicolás Maduro»

«Este vídeo muestra el retiro de las pancartas de Nicolás Maduro»

Ese vídeo es real, pero no es actual, fue grabado en julio de 2024. Las imágenes originalmente se difundieron un día después de las elecciones presidenciales en Venezuela (28 de julio de 2024). El material no está vinculado a una detención, operativo especial de Estados Unidos, como se sugiere en algunas publicaciones actuales.

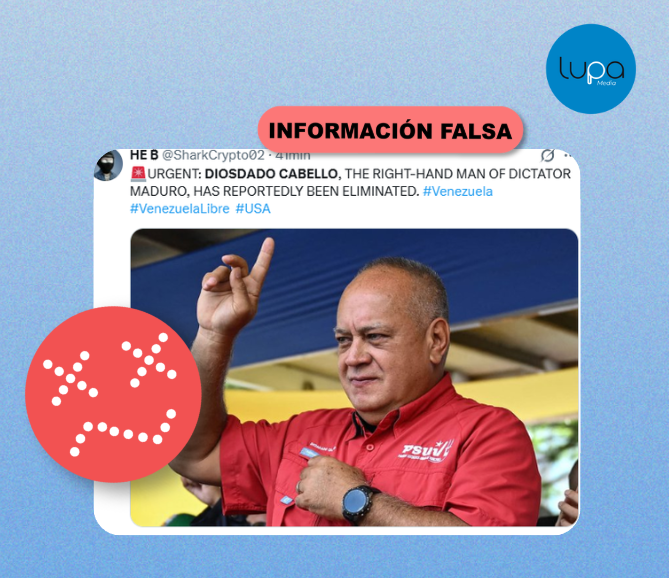

«Diosdado Cabello murió en los bombardeos»

«Diosdado Cabello murió en los bombardeos»

No, es falso que Diosdado Cabello murió en los bombardeos. La desinformación circuló en redes sociales y algunos portales digitales durante las primeras horas de la escalada del conflicto en Venezuela. Sin embargo, Diosdado Cabello apareció horas después en una transmisión en vivo, donde desmintió los rumores sobre su supuesta muerte.

Las imágenes fueron difundidas por el canal estatal Venezolana de Televisión (VTV) y muestran a Cabello activo y acompañado de militares, dirigiéndose a la ciudadanía. No existe evidencia que confirme su fallecimiento. La información que afirmaba lo contrario es falsa.

«Este video es una operación militar de Estados Unidos en Venezuela»

«Este video es una operación militar de Estados Unidos en Venezuela»

Este video viral es una versión manipulada con IA de un video real de una operación militar de Estados Unidos en Venezuela.

Aunque el video original sí corresponde a un hecho auténtico registrado en la madrugada del 3 de enero de 2026, circula una versión fue alterada con IA para añadir explosiones y ataques que no ocurrieron en la grabación original.

«La jefa del Comando Sur de Estados Unidos «confesó» que su país está atacando Venezuela para controlar sus recursos naturales».

«La jefa del Comando Sur de Estados Unidos «confesó» que su país está atacando Venezuela para controlar sus recursos naturales».

FALSO. El clip viral atribuido a Laura J. Richardson está sacado de contexto. Richardson no es actualmente la jefa del Comando Sur de Estados Unidos. Ocupó ese cargo entre 2021 y 2024.

Las declaraciones corresponden a una intervención de 2023, en la que habló de seguridad regional, competencia geopolítica con China y Rusia y de la importancia estratégica de los recursos naturales en América Latina. No afirmó que EE. UU. busque apoderarse del petróleo, el litio o el oro, ni que Venezuela esté siendo atacada por esa razón. El video usa recortes de un discurso real para construir una narrativa falsa.

«Helicópteros Black Hawk de Estados Unidos en Caracas»

«Helicópteros Black Hawk de Estados Unidos en Caracas»

El contenido original fue publicado el 27 de noviembre de 2025 por Jim Ferguson, quien se presenta como “Embajador Internacional” de Advance UK, una organización activista del Reino Unido. La publicación mezcla ese video con una afirmación sobre la llegada de aviones de guerra estadounidenses a Somalia, un hecho que se enmarca en el conflicto de larga data entre Estados Unidos y grupos armados vinculados al Estado Islámico y al Al Shabaab en ese país.

No existe evidencia que relacione ese material audiovisual con operaciones militares de Estados Unidos en Caracas.

«Esta es una imagen de la detención de Maduro»

«Esta es una imagen de la detención de Maduro»

Esta imagen no es real: es IA. En redes sociales circula una imagen que supuestamente muestra la detención de Nicolás Maduro por parte de fuerzas especiales de Estados Unidos, la DEA y el FBI. La imagen no es auténtica y presenta indicios de haber sido creada con inteligencia artificial.

Entre las inconsistencias se observan letras ilegibles en el uniforme de uno de los supuestos soldados y rasgos faciales irregulares, señales frecuentes en contenidos generados con IA.

Además, según informó la cadena estadounidense CBS, fuentes militares de Estados Unidos —que no fueron identificadas— señalaron que la detención habría sido ejecutada por la Fuerza Delta, una unidad élite antiterrorista del Ejército estadounidense, y no por la DEA ni el FBI, como se afirma en la imagen viral.

Asimismo, herramientas de detección de contenido generado con IA, como InVID y SynthID, indican una alta probabilidad de que la imagen haya sido creada con inteligencia artificial.

«Esta imagen es de la captura de Nicolás Maduro»

«Esta imagen es de la captura de Nicolás Maduro»

La imagen de Nicolás Maduro detenido a bordo de USS Iwo Jima es REAL. El contenido fue publicado en el perfil de Truth Social del presidente Donald Trump.

“Índice de pobreza 20.5% (p) el más bajo en 20 años”

“Índice de pobreza 20.5% (p) el más bajo en 20 años” “Inflación en 1.2%”

“Inflación en 1.2%” “Ventas en nivel récord”

“Ventas en nivel récord”

«Daniel Noboa anunció construir una cárcel en Namekusei tras fraude electoral»

«Daniel Noboa anunció construir una cárcel en Namekusei tras fraude electoral»