Lo que dijo la MOE UE sobre desinformación en el proceso electoral

La Misión de Observación Electoral de la Unión Europea (MOE UE) inició su trabajo en Ecuador el 28 de diciembre de 2024. Conformada por 106 observadores desplegados en las 24 provincias, su objetivo fue evaluar todas las etapas del proceso electoral. Además del monitoreo presencial, la misión analizó el contenido circulante en redes sociales para identificar narrativas de campaña vinculadas a la desinformación, la manipulación y el uso de inteligencia artificial.

Con base en ese análisis, la MOE UE elaboró un informe en el que formuló varias recomendaciones para fortalecer futuros procesos electorales. En ese documento, se reconoció la labor de Lupa Media, Ecuador Chequea y AFP Factual como las tres iniciativas de verificación que contribuyeron a contrastar información falsa durante el periodo electoral.

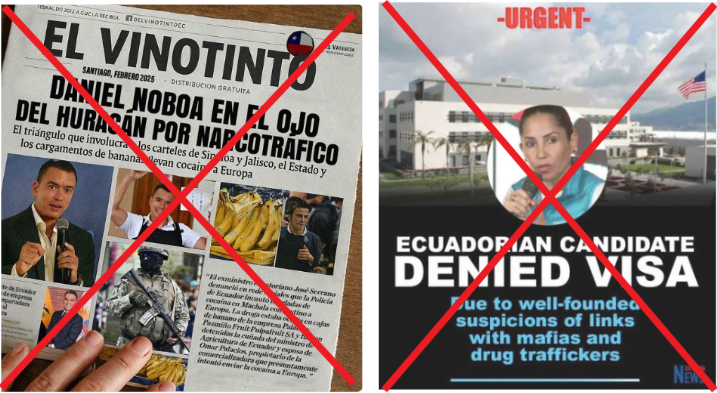

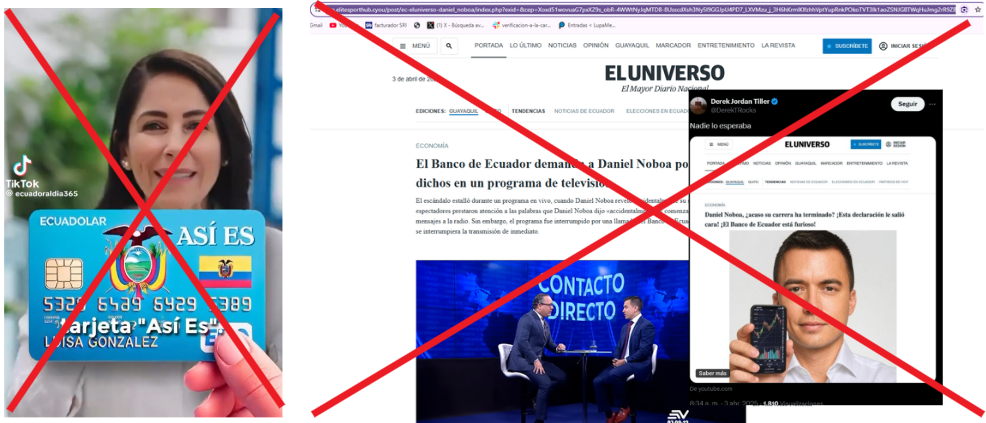

Al igual que Lupa Media , la misión concluyó que las campañas de desinformación se difundieron a través de múltiples plataformas digitales, utilizando cuentas falsas, contenido promocionado, redes automatizadas y suplantación de medios legítimos.

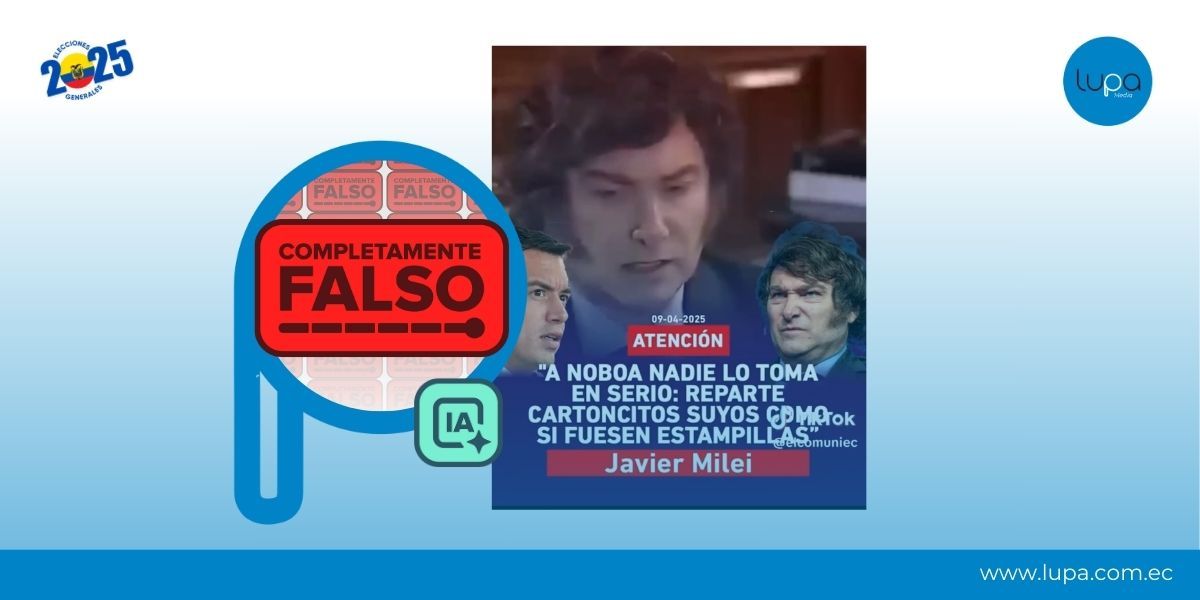

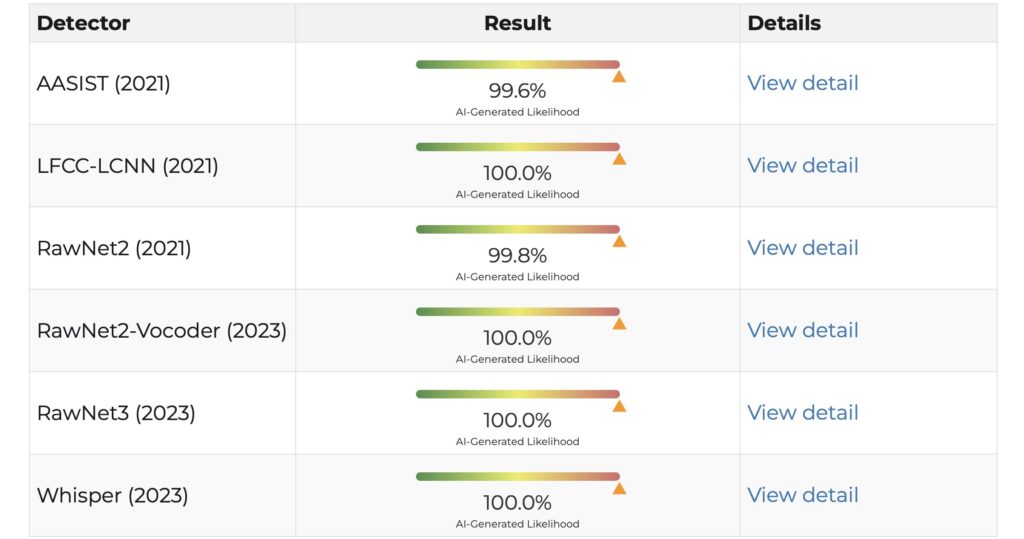

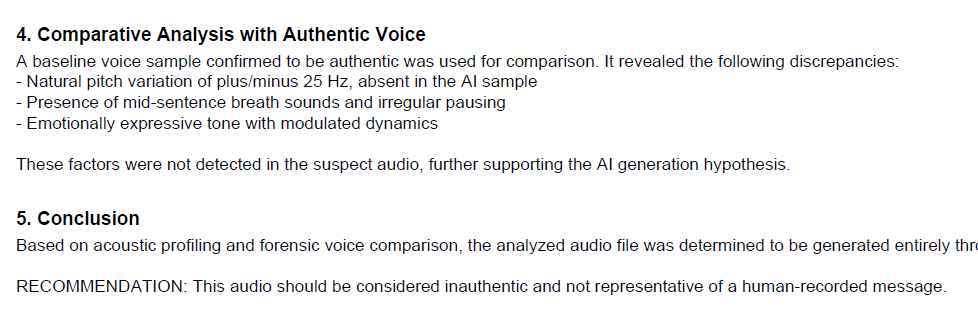

El uso de inteligencia artificial con fines desinformativos fue una de las estrategias más persistentes, especialmente en campañas de difamación.

Aquí te contamos qué observó la misión en torno a la desinformación electoral y cuáles son sus recomendaciones para enfrentarla.

Recomendación 1: Uso de la inteligencia artificial

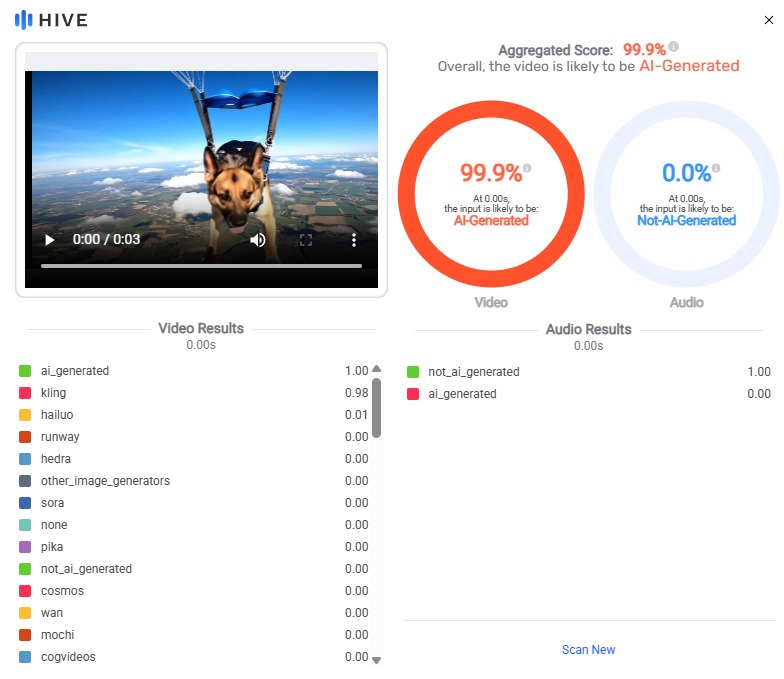

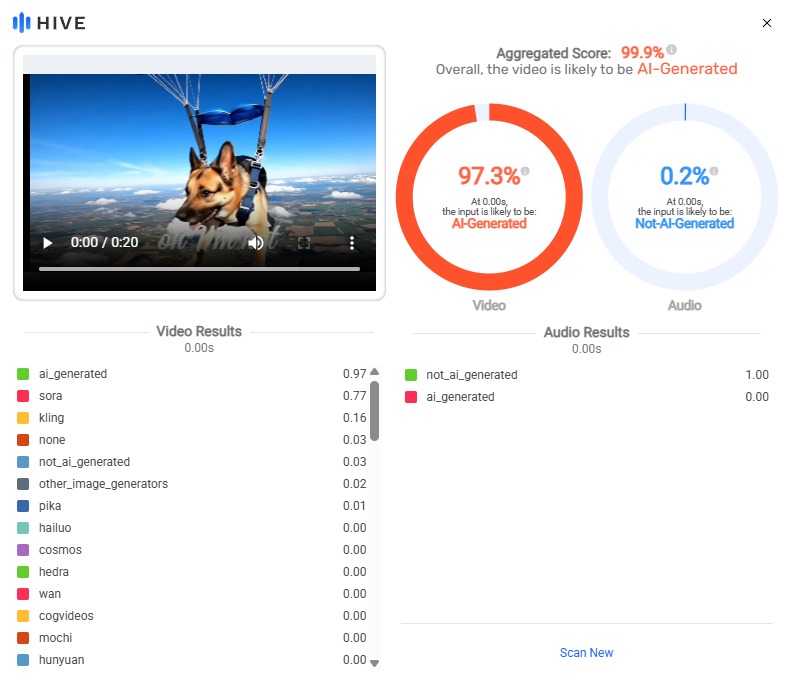

El uso de inteligencia artificial con fines desinformativos marcó un hito en las elecciones recientes, complicando la distinción entre noticias reales y contenidos manipulados. Según el informe la MOE UE, esta dificultad se debe, en parte, al bajo nivel de familiaridad de la mayoría de los votantes con esta tecnología. Además, el volumen de contenido generado por IA creció conforme avanzaba la campaña.

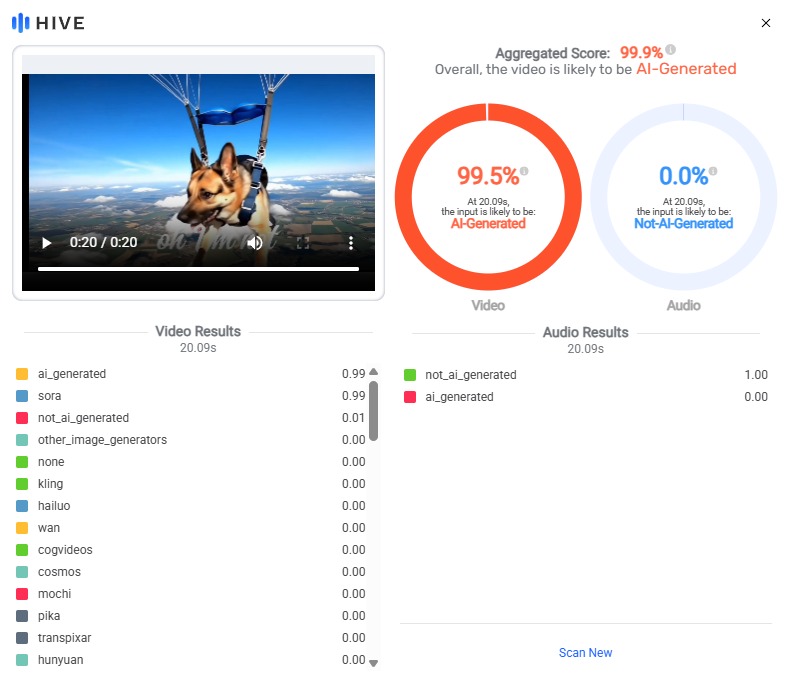

Estas elecciones fueron las primeras en las que se observó una presencia significativa de piezas políticas creadas con inteligencia artificial. La MOE UE documentó 131 casos en los que esta tecnología fue utilizada para alterar videos, imágenes, textos y audios con fines manipulativos. Cerca del 43% de ese contenido fue difundido por cuentas sospechosas de ser bots o trolls.

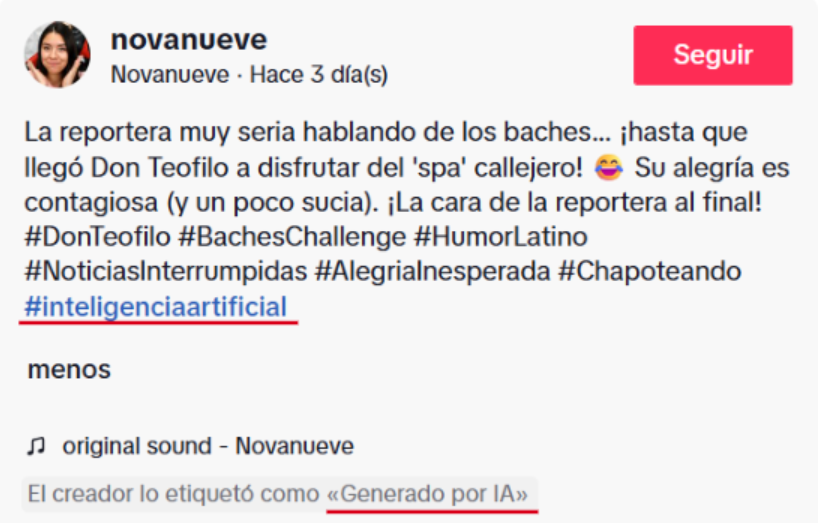

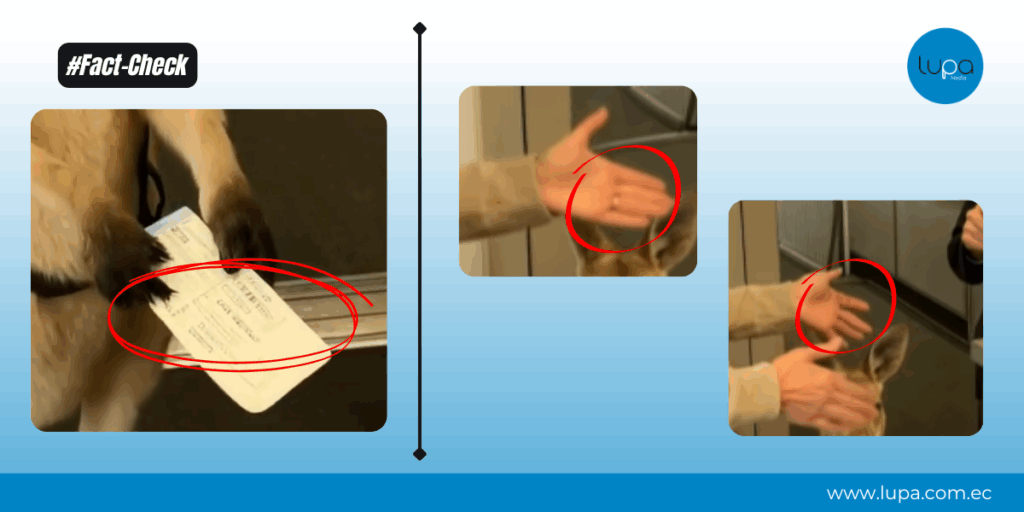

Si bien algunos de estos materiales fueron utilizados en clave humorística o satírica, la mayoría buscaba desinformar y desacreditar a los adversarios políticos. Entre los casos detectados, 63 correspondían a videos manipulados, 55 a imágenes alteradas.

- 27 de los casos observados de IA difundieron simulaban ser reportes de medios confiables.

Frente a este panorama, la MOE UE recomendó reforzar la cooperación entre el Consejo Nacional Electoral (CNE), medios de comunicación, organizaciones de la sociedad civil, academia y plataformas tecnológicas. Propuso desarrollar campañas de concientización enfocadas en la desinformación generada por IA y fomentar la alfabetización mediática y digital, especialmente en contextos electorales.

Recomendación 2: Código de conducta

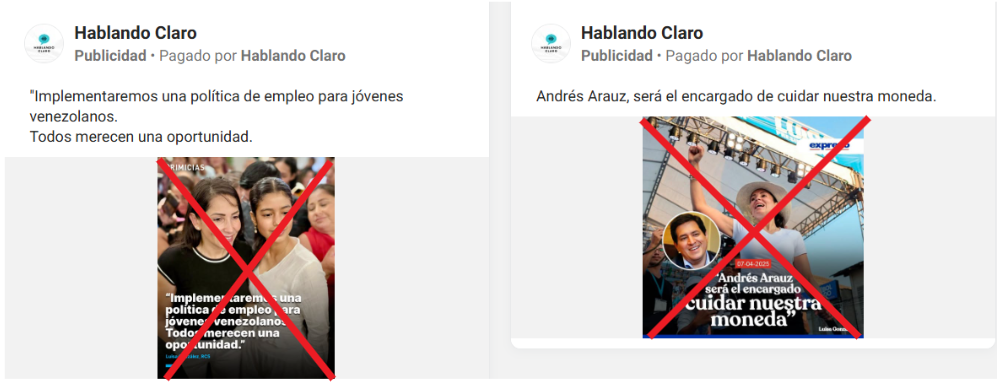

La MOE UE identificó la presencia de sitios web y cuentas en redes sociales que se hacían pasar por iniciativas de verificación, pero que en realidad difundían contenido engañoso. Según el informe, incluso durante el primer debate presidencial, el entonces candidato y actual presidente Daniel Noboa respaldó públicamente algunas de estas cuentas como fuentes confiables.

Frente a este escenario, la misión recomendó fomentar la adopción de un código de conducta por parte de los partidos políticos, que incluya el compromiso de no producir ni difundir desinformación, contenidos dañinos o publicidad política sin la debida identificación. Esta sugerencia se basa en principios internacionales vinculados a la libertad de expresión, la transparencia y el acceso a la información.

El informe también observó que algunas instituciones públicas utilizaron sus perfiles oficiales para desmentir información falsa. Sin embargo, la MOE UE cuestionó esa práctica, señalando que, en muchos casos, las publicaciones carecían de una metodología clara, contenían datos inexactos o se realizaban desde una postura poco imparcial

La misión enfatizó que este tipo de respuestas no puede considerarse verificación en sentido estricto, ya que no cumple con los principios fundamentales del fact-checking: independencia, apartidismo y transparencia.

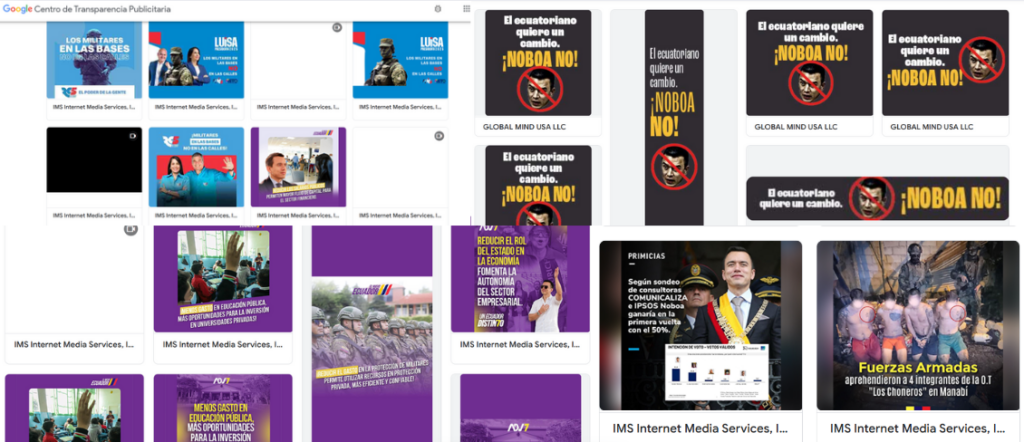

Recomendación 3: Transparencias en el gasto de publicidad

La misión internacional advirtió que herramientas como Google Ads (plataforma de publicidad) fueron utilizadas no solo para promocionar candidaturas, sino también para atacar adversarios políticos y difundir desinformación. Sin embargo, la misión no logró rastrear la identidad de los anunciantes ni verificar el origen de los fondos utilizados para este tipo de campañas.

Ante la falta de transparencia, la MOE UE recomendó fortalecer la cooperación entre el Consejo Nacional Electoral (CNE) y las plataformas tecnológicas, con el objetivo de facilitar un monitoreo más riguroso del gasto en publicidad digital durante las campañas. Esta información debería ser accesible y supervisada de forma sistemática por el organismo electoral.

Durante su monitoreo, la misión identificó diversas estrategias utilizadas para amplificar la desinformación en línea:

- Creación de cuentas nuevas durante el periodo electoral destinadas a difundir mensajes engañosos mediante anuncios pagados.

- Presencia activa de cuentas de trolls en múltiples plataformas.

- Perfiles que simulaban ser medios de comunicación para publicar encuestas falsas o contenido de opinión disfrazado de información.

- Usurpación de la identidad de medios nacionales e internacionales.

- Páginas de Facebook que patrocinaban publicaciones orientadas a desacreditar a determinados candidatos.

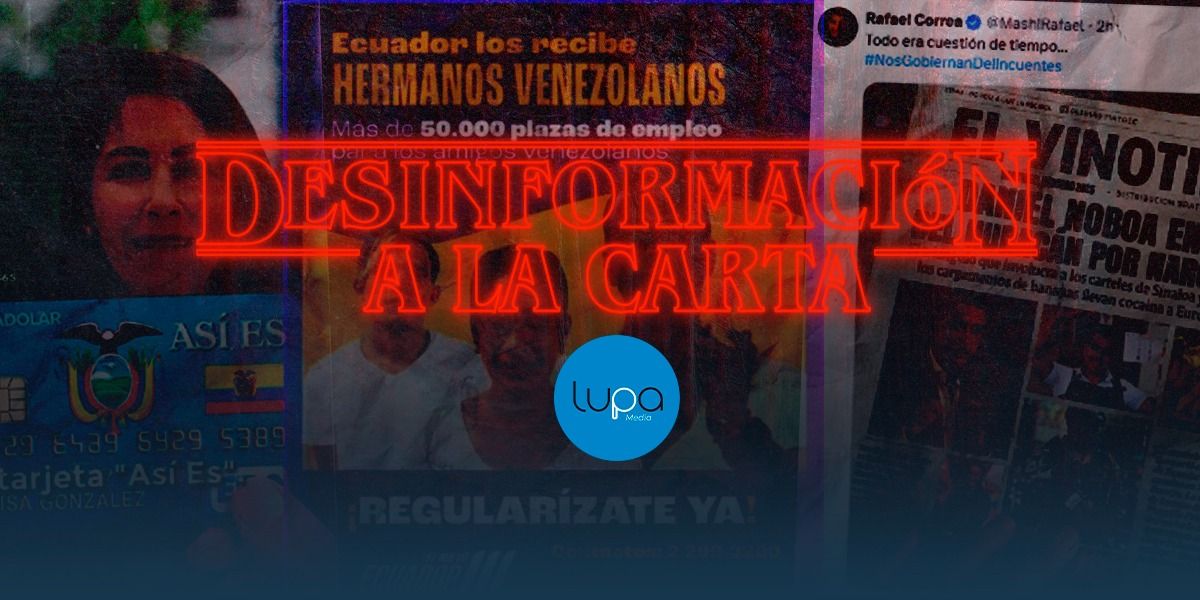

Desinformación a la carta

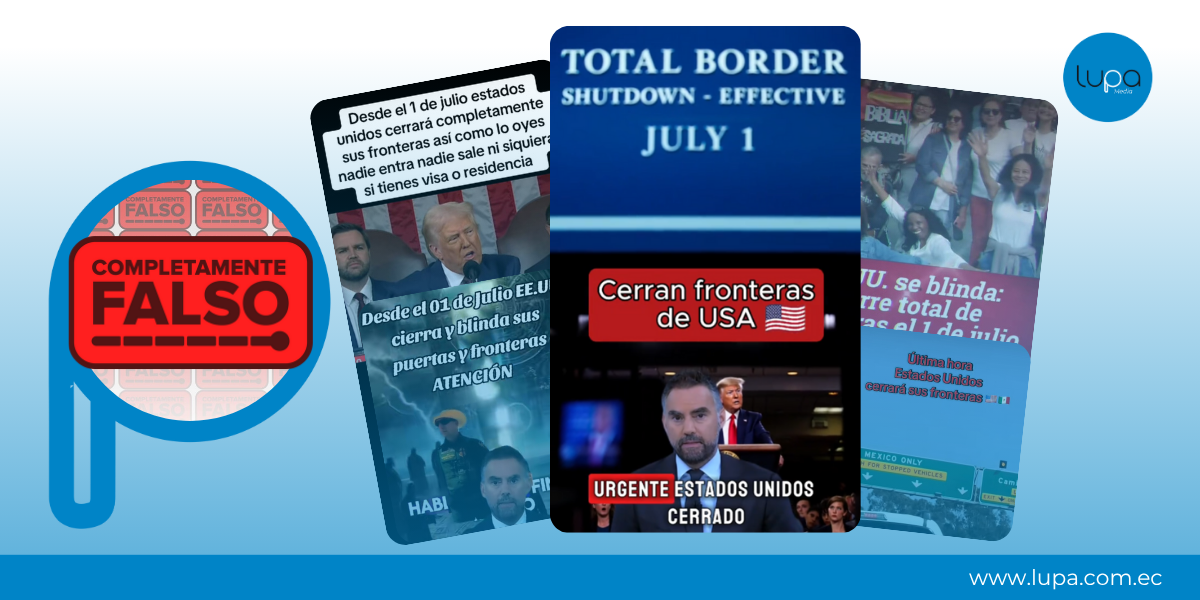

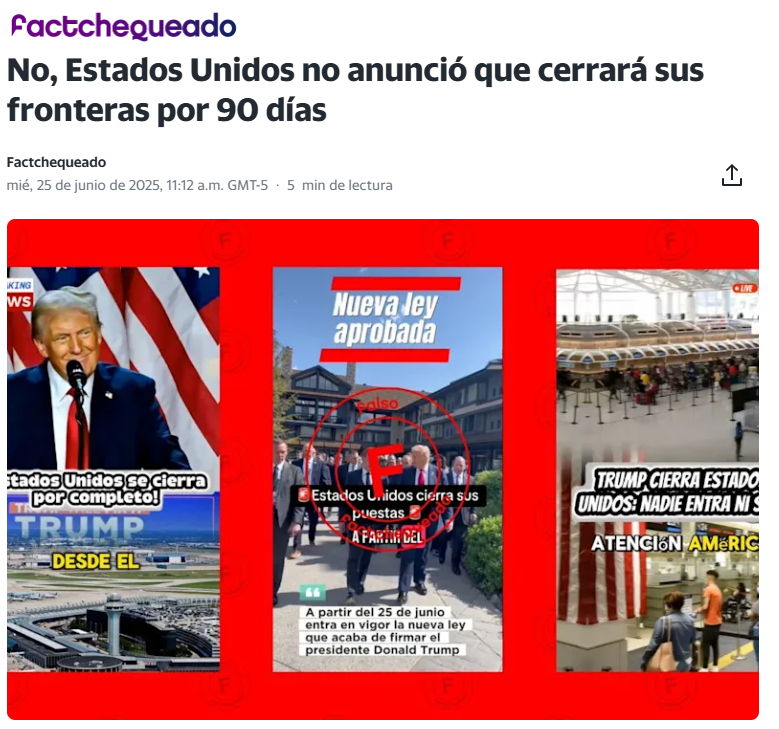

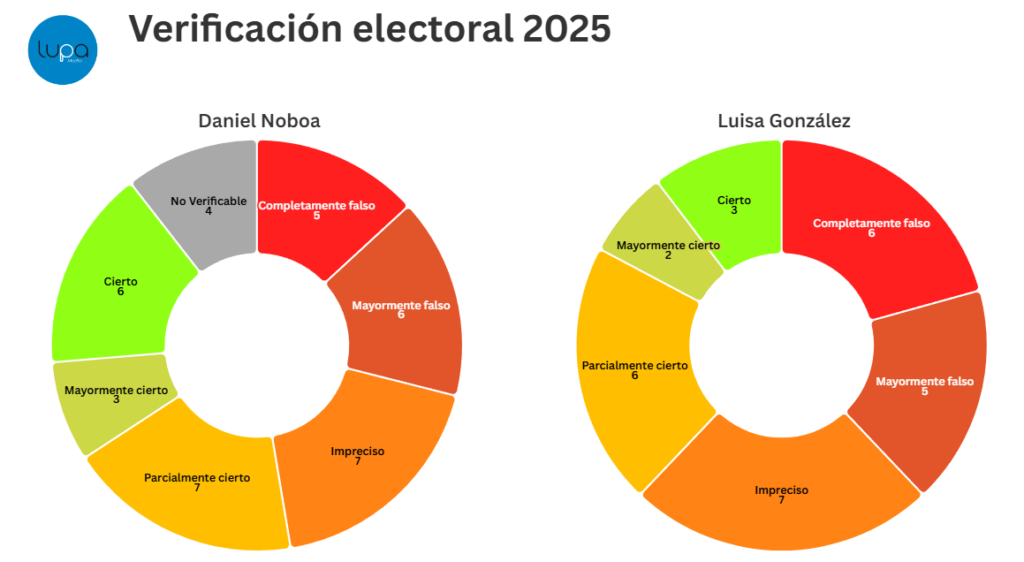

Durante toda la campaña electoral, Lupa Media verificó 247 contenidos virales, del cual un 74% resultaron ser falsos. El 19,6% de estos eran contenidos manipulados o generados con IA.

🔍#FactCheckLupa | Durante las elecciones presidenciales de 2025 en Ecuador, la desinformación se sirvió “a la carta”: sofisticada, emocional y diseñada para polarizar.

— Lupa Media (@LupaMediaEC) April 9, 2025

🧐Verificamos 247 contenidos virales entre enero y abril. El 74% resultó falso. La mayoría circuló en X,… pic.twitter.com/kV473c2KP1

Las narrativas estuvieron centradas en su mayoría en los dos candidatos principales: Daniel Noboa y Luisa González. Además, las temáticas principales que surgieron como fuentes de desinformación fueron:

- Migración.

- Narcotráfico.

- Dolarización.

- Fraude electoral.

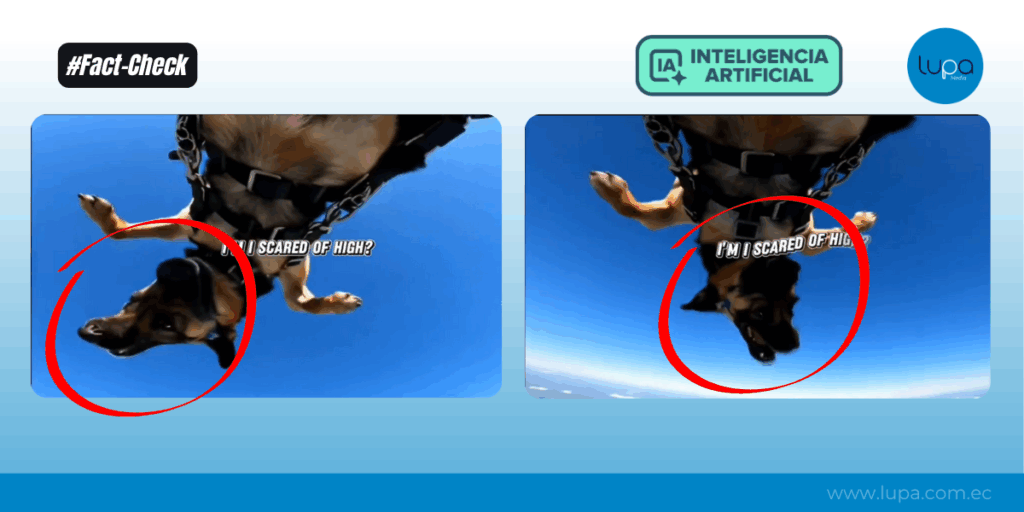

También se identificó la creación de cuentas falsas que suplantaban a medios y candidatos políticos con el fin de redirigir a páginas fraudulentas. Así como la creación de noticieros falsos que eran presentados por avatares generados con IA para simular reportajes reales.