La IA y la desinformación sobre el conflicto entre Irán e Israel-Estados Unidos

El conflicto entre Israel e Irán, escaló el 13 de junio y ha desatado una ola de desinformación con contenidos que manipulan la realidad. Tras el ingreso de Estados Unidos al conflicto, con el bombardeo a instalaciones nucleares en Irán el 22 de junio, las publicaciones sintéticas continúa propagándose sin límites. La inteligencia artificial gana terreno, y en Lupa Media verificamos algunos de ellos. Pero antes analicemos el contexto de la IA en este conflicto.

El uso de la IA en este conflicto bélico

Según Emmanuelle Saliba, directora de investigación del grupo de analistas Get Real, esta es “la primera vez que hemos visto que la IA generativa se usa a escala durante un conflicto”. En una entrevista con BBC Verify, la investigadora explicó que muchos de estos contenidos sintéticos están ambientados de noche, lo que dificulta su verificación debido a la escasa visibilidad de los elementos en las imágenes.

En este conflicto, la inteligencia artificial ha sido utilizada para simular supuestas capacidades militares, consecuencias de bombardeos, protestas, reuniones e incluso apoyos políticos inexistentes. Estos contenidos son producidos y difundidos por creadores que buscan beneficiarse del conflicto captando la atención de los usuarios. A cambio, ganan visibilidad y seguidores. Algunas de estas cuentas aparentan ser «oficiales», pero no existe claridad sobre su autenticidad.

Las motivaciones detrás de estos contenidos falsos son variadas. Algunas cuentas buscan monetizar los contenidos fabricados y han sido previamente identificadas por propagar desinformación en otros conflictos bélicos. Incluso, algunos de estos videos generados con IA han sido replicados por fuentes oficiales tanto de Irán como de Israel.

Matthew Facciani, investigador de la Universidad de Notre Dame, explicó a la BBC que la desinformación se propaga más rápido en contextos de guerra, donde predominan narrativas «binarias» y polarizadas.

En escenarios polarizados, la verdad emocional cobra peso: las personas tienden a reforzar sus creencias o preferencias geopolíticas, incluso cuando la guerra ya ofrece suficientes escenarios crueles y reales. La inteligencia artificial se convierte entonces en una herramienta para amplificar emociones y profundizar divisiones.

Aquí un par de verificaciones sobre el uso de la IA con el fin de desinformar acerca del conflicto entre Irán e Israel.

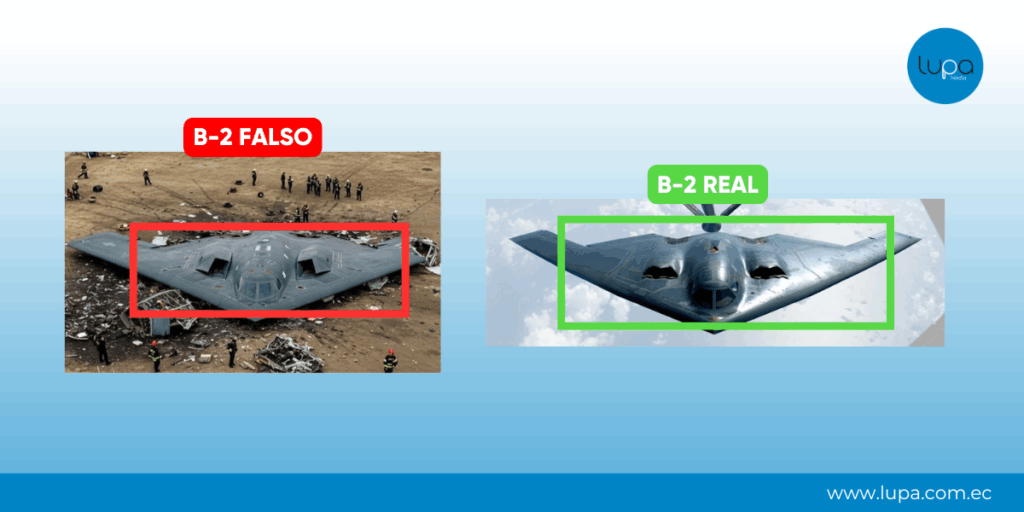

“Imagen muestra un bombardero de B-2 que fue derribado por Irán antes de que alcanzara la instalación nuclear de Fordow”

“Imagen muestra un bombardero de B-2 que fue derribado por Irán antes de que alcanzara la instalación nuclear de Fordow”

Una imagen viral muestra supuestamente cómo Irán derriba un bombardero estadounidense B-2 Spirit antes de que impacte contra la planta nuclear subterránea de Fordow. Sin embargo, se comprobó que la imagen fue generada con inteligencia artificial. Este contenido engañoso surgió tras el ataque del 22 de junio, cuando Estados Unidos lanzó una ofensiva con siete bombarderos B-2 Spirit contra tres instalaciones nucleares en Irán.

Según reportó la agencia Associated Press, varios de estos bombarderos regresaron a su base en Whiteman en Missouri. Además, el modelo B-2 Spirit utilizado en el ataque no coincide con el de la imagen viral: presenta claras diferencias de diseño respecto a un bombardero real de este tipo.

La plataforma “Detect AI Generated Images” determinó con un 99 % de probabilidad que la fotografía fue creada con inteligencia artificial. Además, equipos de verificación de medios como la BBC y Newtral desmintieron la imagen, confirmando que se trata de contenido generado por IA.

Fuentes:

Búsqueda inversa de imágenes con Google Lens

Detect AI

BBC Verify – El conflicto entre Israel e Irán desencadena una ola de desinformación sobre la IANewtral – Esta imagen de un bombardero estadounidense B-2 supuestamente derribado por Irán está generada con IA – 23/06/25

Associated Press – Vea el regreso de los bombarderos B-2 involucrados en el ataque de

Estados Unidos contra Irán a la base de la Fuerza Aérea de Missouri – 22/06/25

Newtral – Esta imagen de un bombardero estadounidense B-2 supuestamente derribado por Irán está generada con IA – 23/06/25

“Video muestra cómo Estados Unidos lanza bombas nucleares en Irán”

“Video muestra cómo Estados Unidos lanza bombas nucleares en Irán”

Un video viral muestra la explosión de una supuesta bomba nuclear y asegura que Estados Unidos está destruyendo reactores nucleares en Irán. Pero ese contenido fue creado con IA. Aunque Estados Unidos sí bombardeó contra las instalaciones nucleares de Irán: Fordow, Natanz e Isfahán, el contenido viral no corresponde a este ataque.

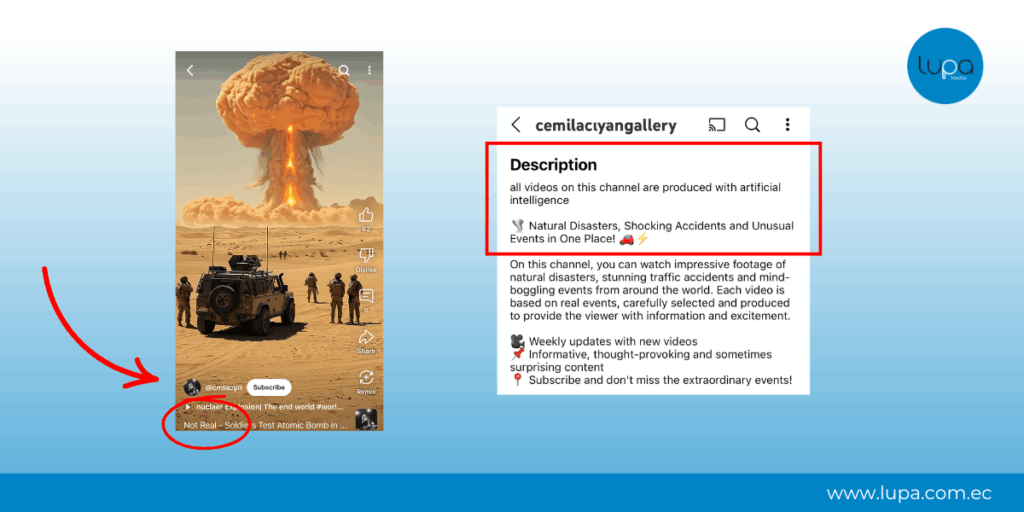

Una búsqueda inversa con Google Lens reveló que el video original fue publicado por una cuenta dedicada a compartir contenido generado con IA. En su biografía, esta cuenta advierte que todos sus videos son producidos con inteligencia artificial sobre desastres naturales, accidentes y eventos ficticios.

Lupa Media ya verificó un contenido similar relacionado con el conflicto actual en Medio Oriente. En ese caso, el propio usuario confirmó al medio de verificación español Newtral que las imágenes publicadas en su cuenta fueron creadas por él utilizando inteligencia artificial.

Fuentes:

Búsqueda de palabras clave

Búsqueda inversa de imágenes con Google Lens

Análisis de la cuenta de YouTube que comparte contenido con IA

“Video muestra el ataque más fuerte de Irán en contra de Israel”

“Video muestra el ataque más fuerte de Irán en contra de Israel”

Este contenido muestra supuestamente explosiones en Tel Aviv tras un bombardeo iraní contra Israel. Sin embargo, no existe evidencia de que haya ocurrido un ataque de esa magnitud desde el inicio del conflicto entre ambos países.

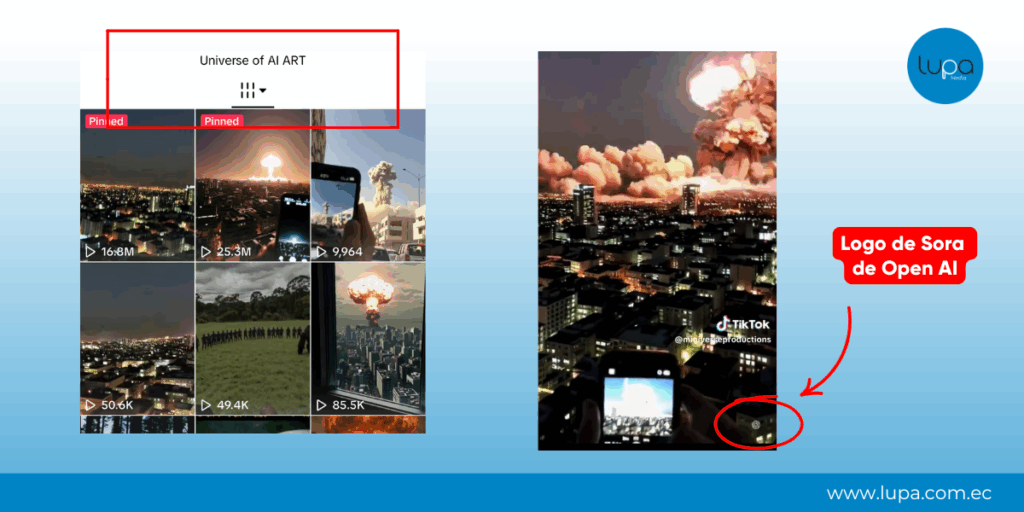

Una búsqueda inversa con Google Lens reveló que el video original fue publicado en TikTok el 21 de abril de 2025 y acumula más de 16,8 millones de visualizaciones. El clip incluye la etiqueta “Generado por IA”, colocada por el propio creador, y no hace ninguna referencia al actual conflicto en Medio Oriente.

Además, en la esquina inferior derecha aparece el logo de Sora, la herramienta de generación de video con inteligencia artificial desarrollada por OpenAI.

La cuenta publica varios videos similares que simulan escenas de guerra, todos etiquetados como contenido generado con inteligencia artificial. Incluso, en la descripción se incluye la frase: ‘Universo de arte con IA’. Se trata, por tanto, de una cuenta dedicada a compartir material fabricado que no refleja hechos catastróficos reales ni actuales.

Fuentes:

Búsqueda de palabras clave

Búsqueda inversa de imágenes con Google Lens

Análisis de la cuenta de TikTok que comparte contenido con IA

Newtral – Este vídeo no muestra varias explosiones en Tel Aviv tras un ataque de Irán, es IA – 19/06/25

“Video evidencia un desfile de misiles iraníes para atacar a Israel”

“Video evidencia un desfile de misiles iraníes para atacar a Israel”

En redes circula un video viral en el que se muestra un desfile de camiones saliendo de lo que parece ser una cueva, transportando supuestos misiles iraníes. Sin embargo, ese contenido fue generado con IA.

Varias inconsistencias gráficas revelan la falsedad del video: las piedras en la parte inferior derecha se mueven por sí solas y las paredes de la cueva parecen difuminarse. Al igual que otros videos virales similares, este contenido también ha sido verificado por BBC Verify.

Subimos fotogramas del video a la plataforma “Detect AI Generated Images”, que indicó un 94 % de probabilidad de que las imágenes fueron generadas con inteligencia artificial. Este alto porcentaje, sumado a las incongruencias visuales señaladas, confirma la fabricación del video.

Fuentes:

Búsqueda inversa de imágenes con Google Lens

Detect AI

BBC Verify – El conflicto entre Israel e Irán desencadena una ola de desinformación sobre la IA – 23/06/25

Contexto importante

El 22 de junio, Estados Unidos se unió a Israel en los ataques contra Irán, que habían comenzado nueve días antes. En esta escalada del conflicto en Medio Oriente, bombarderos estadounidenses atacaron instalaciones nucleares en Fordow, Natanz e Isfahán. El objetivo de EE.UU. es detener el programa nuclear iraní, que según sus declaraciones, estaba cerca de desarrollar armamento de ese tipo. Por su parte, Irán negó la intensión de generar una bomba nuclear y promete una «respuesta decisiva» al ataque de Estados Unidos.

Un día después, durante la noche en la zona horaria de Medio Oriente, Irán respondió lanzando misiles contra bases estadounidenses en Catar e Irak.

En Lupa Media te explicamos los detalles clave de la ofensiva estadounidense en Irán y las posibles consecuencias de este conflicto.

🔍 #LupaTeExplica | 💣Estados Unidos bombardeó tres instalaciones nucleares en Irán y entró de lleno en un conflicto que ya enfrentaba a Israel y Teherán.

— Lupa Media (@LupaMediaEC) June 22, 2025

🔥 El impacto es global: escalada militar, tensiones diplomáticas y mercados en alerta.

Aquí te explicamos lo que tienes… pic.twitter.com/qBKFs1zfiu