TikTok e IA: el peligro del contenido sexual infantil

Advertencia de contenido: esta investigación aborda temas sensibles relacionados con sexualización de menores y pornografía infantil.

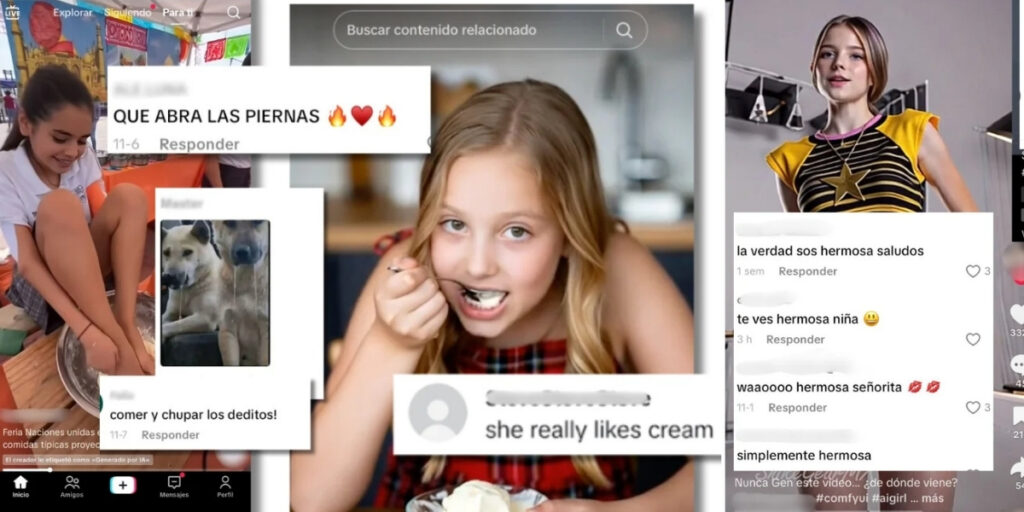

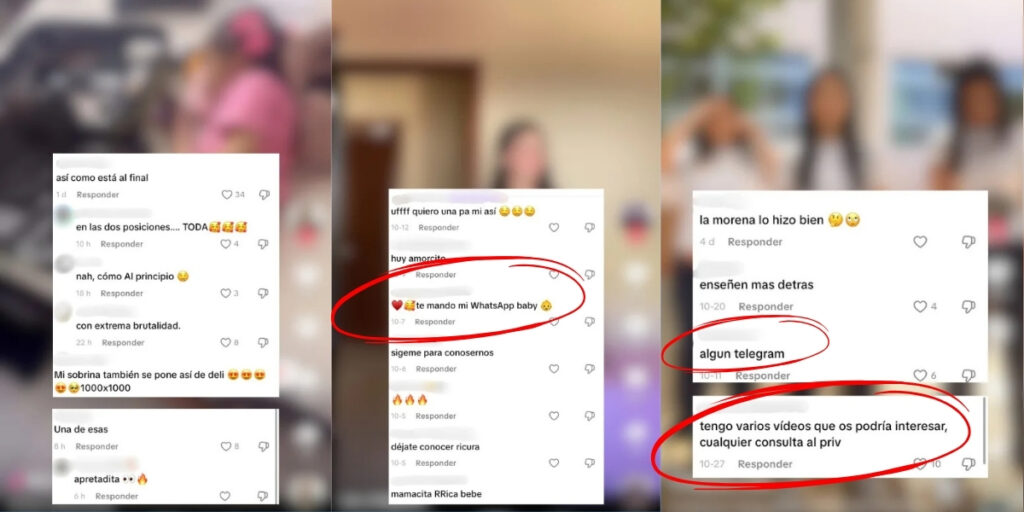

Las protagonistas suelen ser niñas pequeñas y chicas adolescentes, pero las situaciones en las que las representan varían. El factor común: las publicaciones se llenan de comentarios en las que usuarios (muchos con fotos de perfil de hombres adultos) las sexualizan, incluso con mensajes sexualmente explícitos, o les dejan emojis de corazones y fuegos.

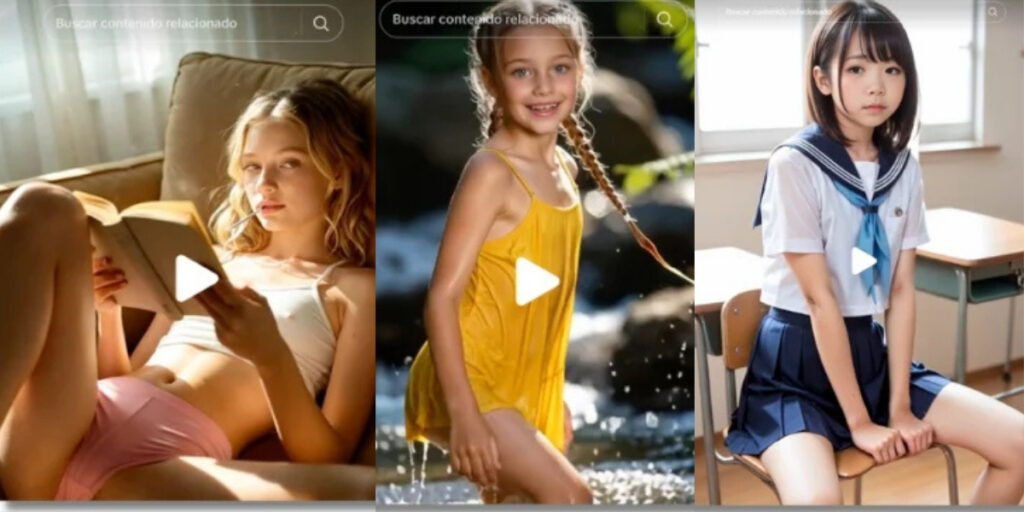

Hay decenas de contenidos creados con IA que muestran a las menores en bikini o usando ropa ajustada: los vídeos se enfocan en mostrar los pechos y piernas de las supuestas menores. También se repiten los vídeos de ellas saltando, ya sea usando ropa deportiva que marca sus genitales y pezones, o con uniforme escolar.

Otros, a primer vistazo, pueden parecer más inocentes, ya que las menores aparecen vestidas. Pero no lo son, como revelan los comentarios en diferentes idiomas. Hay videos que muestran a niñas sacando la lengua o comiendo helado con mensajes de usuarios que dicen “hasta el fondo” o “tienen que aprender tarde o temprano”.

La IA de TikTok y Sora, las herramientas utilizadas

Todas las cuentas analizadas por Maldita.es usan la etiqueta de “contenido generado con IA” de TikTok o algún hashtag o comentario donde revelan el origen sintético de sus contenidos. Sin embargo, la mayoría de los videos analizados no tienen marcas de agua visibles que revelen con qué herramientas fueron creados.

Hay algunas excepciones. Uno de los perfiles analizados publicó varios videos de niñas y adolescentes en bikini con la marca de agua de TikTok AI Alive, una función que usa inteligencia artificial para “transformar fotos estáticas en vídeos dinámicos e inmersivos”, según TikTok. Otra de las cuentas (que redirige a X, donde publica enlaces a una web de pornografía) tiene varios vídeos de animadoras y chicas con uniforme escolar y de sirvienta saltando en las que aparece la marca de agua de Sora, la herramienta de creación de video de OpenAI.

‘Colegialas’, el tema favorito de los pedófilos

Una niña juega en una piscina. Unas estudiantes bailan en el patio de su instituto. Una adolescente canta a la cámara. Todas son escenas comunes de TikTok pero agrupadas en estos perfiles con descripciones como “colegialas primaria, secundaria, prepa”, “me encantan las diosas de todo el mundo” y “las más lindas de los colegios”, el tono cambia. Las 20 cuentas que analizadas se dedican a recopilar videos de chicas, en muchos casos con uniforme o ambientados en espacios escolares. De hecho, 11 de los perfiles usan la palabra “colegiala” en el nombre de la cuenta.

Los videos de menores son reales, reutilizados desde sus cuentas originales; a veces ocultan la marca de agua para evitar rastrearlas. Es el caso de un video que muestra a dos adolescentes bailando (que ha sido visto 193.000 veces), lleno de comentarios de usuarios que piden sus nombres. Uno contesta citando el perfil de la chica que lo publicó originalmente que, según su biografía, tiene 16 años.

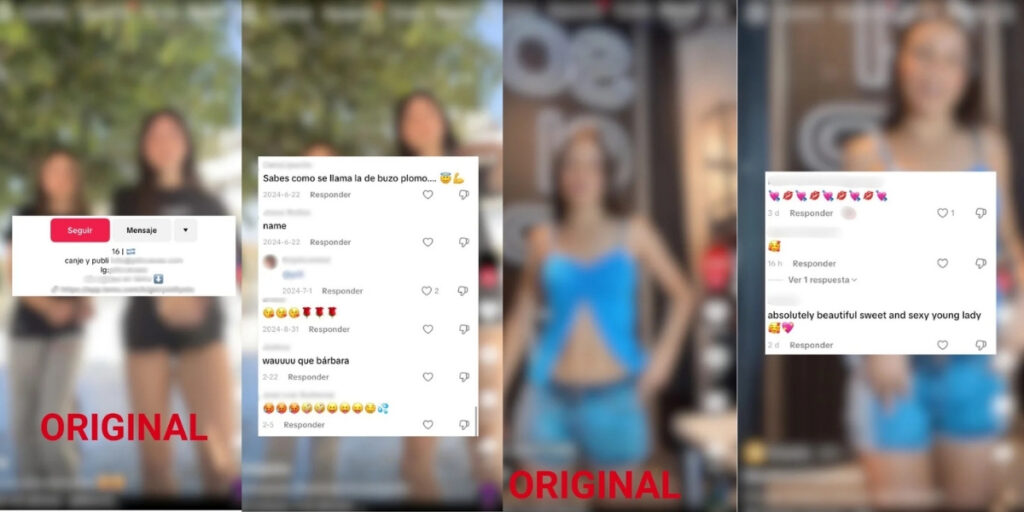

Otra cuenta analizada, con 1.851 seguidores, recopila los vídeos que publicó originalmente una tienda de ropa argentina donde aparecen chicas con apariencia de ser menores modelando. En las publicaciones de la tienda no hay comentarios, pero sí en las del perfil que los republica: están llenos de mensajes de usuarios (muchos con fotos de perfil de hombres adultos) que las llaman “sexi”, les dejan emojis de corazones e imágenes con insinuaciones sexuales.

Una actividad lucrativa

La cosa puede no quedarse solo en comentarios, porque la pornografía infantil está al alcance de cualquiera de estos usuarios en tan solo cinco minutos: entre los comentarios se promocionan cuentas de Telegram que venden e intercambian pornografía infantil real. Varias de las cuentas analizadas redirigieron, ya sea a través del enlace vinculado en sus biografías o por mensaje directo, a sitios web donde se venden vídeos e imágenes sexuales de menores creados con IA.

Además, seis de los 20 perfiles que publican estos contenidos creados con IA que sexualizan a menores usan el sistema de suscripción de TikTok, que permite cobrar por contenido exclusivo y funciones adicionales. Las suscripciones cuestan una media de USD 4,18. De estas ganancias, una parte va a la red social (el 50% después de la comisión de la plataforma de pago de iOS o Google del 15-30%, según explican en su web).

Videos con niñas irreales pueden normalizar la sexualización infantil

“Aunque no representen a niños reales, estos contenidos son profundamente problemáticos”, advierte Mamen Bueno, psicóloga sanitaria y psicoterapeuta. Según la experta, videos como los analizados por Maldita.es pueden “normalizar la sexualización infantil y reforzar patrones de consumo en personas con intereses dañinos hacia menores”. Silvia Catalán, psicóloga experta en sexualidades, añade que el problema radica en “perpetuar una imagen erótica y sexual de los cuerpos pequeños”, lo que dificulta distinguir lo permitido de lo éticamente inadmisible y puede alimentar la demanda hacia menores reales.

Estudios muestran que la sexualización conduce a la deshumanización y puede afectar la salud mental de los menores, provocando desórdenes alimenticios, baja autoestima y depresión, según la Asociación Americana de Psicología. El algoritmo de TikTok amplifica estos riesgos al recomendar contenido similar y perfiles que aparentan ser menores, aumentando la exposición a miradas potencialmente dañinas y el riesgo de captación, grooming o acoso, concluye Bueno.

Tras denunciar 15 de estas cuentas por incumplir las normas de TikTok, todas siguen estando disponibles

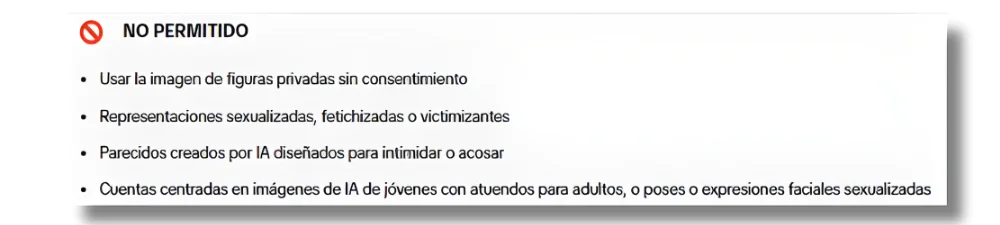

Aunque TikTok prohíbe las cuentas que muestran imágenes generadas con IA que sexualizan o fetichizan a menores, los 15 perfiles que Maldita.es denunció siguieron activos 72 horas después. La plataforma solo aplicó restricciones temporales a una de ellas y consideró que la mayoría no infringía sus políticas.

En ese sentido, las redes sociales como TikTok sólo tienen obligación de eliminar un video si tienen “conocimiento efectivo” de que es ilegal, según la Ley de Servicios Digitales en España (DSA). Así lo explicó a Maldita.es Rahul Uttamchandani, abogado especializado en tecnología y privacidad.

¿Qué podemos hacer si nos encontramos con estos vídeos?

En España, si la menor está a nuestro cargo, Judel explica que podemos denunciar por la vía civil y solicitar una indemnización por los posibles daños y perjuicios ocasionados. Esta puede variar según el alcance de la difusión, el daño reputacional y el contexto: “Si hay un patrón de recolección sistemática de vídeos de niñas o adolescentes para fines fetichistas, la responsabilidad civil se dispara, y la indemnización también”, afirma.

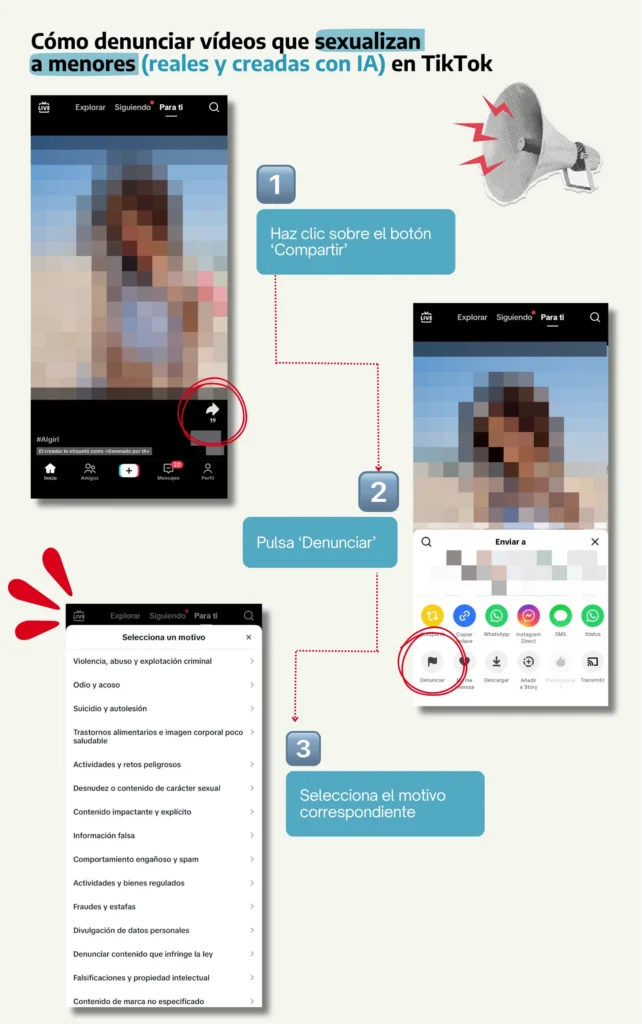

Como usuarios, podemos denunciar este tipo de contenido para que conste que las plataformas han sido notificadas. Para hacerlo, en TikTok debemos pulsar el botón ‘compartir’, presionar ‘denunciar’ y seleccionar el motivo correspondiente.

Fuentes:

Maldita.es – Depredadores en TikTok: una mina para los pedófilos , publicado el 11 de diciembre de 2025.