“Oye Grok” y el uso de chatbots para verificar

Desde el lanzamiento de Grok en agosto de 2024, una nueva versión de chatbot creada por Elon Musk, esta tecnología ha sido utilizada ampliamente para generar contenido y, más recientemente, para intentar verificar información.

Sin embargo, la aparente objetividad y neutralidad de estos chatbots pueden convertirse en un problema serio cuando se trata de verificar datos. Los modelos de IA, como Grok, pueden incurrir en un fenómeno conocido como «falso balance», donde presentan opiniones contrarias como si tuvieran el mismo peso, distorsionando así la percepción de la realidad.

La trampa de la neutralidad forzada

Modelos de lenguaje como Grok, ChatGPT o DeepSeek tienden a evitar tomar partido en temas controvertidos, incluso cuando existe evidencia clara que respalda una posición sobre otra. Esto da lugar a un sesgo de equidistancia artificial, en el que se presentan argumentos desiguales en respaldo científico como si fueran equivalentes.

«Aunque la intención de estos sistemas puede ser mostrar imparcialidad, lo que logran es distorsionar la realidad al presentar como igual lo que no lo es», explica Julián Estévez, profesor de ingeniería en la Universidad del País Vasco, en una entrevista con Maldita.es.

Según Open Ethics, una institución dedicada a investigar los impactos sociotecnológicos de la IA, uno de los problemas es que «al intentar ser neutrales, los sistemas de IA pueden fallar en captar la diversidad, los matices y el contexto de los valores humanos, lo que puede resultar en respuestas sesgadas o inexactas«. Por ejemplo, una IA puede ofrecer respuestas equidistantes sobre temas controvertidos sin considerar las diferencias en la calidad de las pruebas que existen para cada postura.

Iris Domínguez, investigadora en inteligencia artificial y justicia algorítmica, señala que al preguntar a un chatbot si el cambio climático es real, la respuesta generalmente es clara y respaldada por la ciencia. Pero si la pregunta es «¿El ecologismo ha ido demasiado lejos?», muchas veces la IA presentará ambas posturas por igual, aunque la evidencia científica no las respalde en la misma medida.

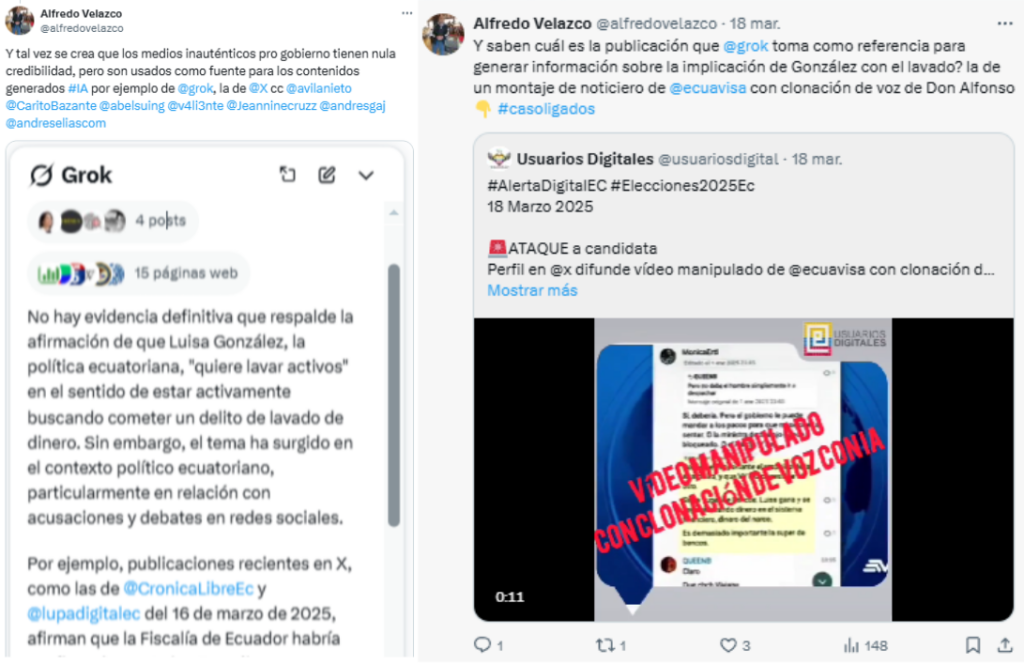

Este tipo de «neutralidad forzada» puede contribuir a la desinformación, especialmente cuando los chatbots presentan afirmaciones sin contexto adecuado o evitan desmentir teorías falsas con suficiente contundencia. Un caso reciente que ilustra este peligro ocurrió cuando la organización civil ecuatoriana Usuarios Digitales consultó a Grok si la candidata presidencial Luisa González estaba implicada en lavado de activos. La respuesta del chatbot incluyó información que hacía referencia a vídeos manipulados, previamente verificados.

La manipulación de los chatbots: el ‘LLM grooming’

Los riesgos no se limitan a la neutralidad forzada. Existe una táctica llamada «LLM grooming», en la que redes de desinformación alteran los resultados de los chatbots al modificar los datos con los que se entrenan. Este proceso se lleva a cabo al inundar los buscadores y rastreadores web con contenido automatizado y manipulador. Como resultado, los modelos de IA recogen estos datos sesgados e incluyen narrativas falsas en sus respuestas.

Un ejemplo reciente lo ha mostrado NewsGuard, que identificó que la red prorrusa Pravda logró manipular los datos de entrenamiento de varios chatbots mediante el «LLM grooming». Como consecuencia, un 33% de los chatbots analizados replicaron narrativas falsas difundidas por esta red.

¿Son los chatbots aliados de la verificación?

Aunque los chatbots pueden ser herramientas útiles para acceder a información rápidamente, su fiabilidad como fuentes de verificación es cuestionable. Están sujetos a sesgos inherentes en sus datos de entrenamiento y también pueden ser manipulados por técnicas externas como el «LLM grooming».

Para mejorar la precisión de estos modelos, expertos sugieren que la selección de datos de entrenamiento sea más transparente y se base en fuentes verificadas. Sin embargo, es importante subrayar que los chatbots no pueden reemplazar el análisis crítico y la verificación profesional.

Los usuarios deben ser conscientes de las limitaciones éticas y prácticas de esta tecnología. Por ejemplo, un modelo como Grok no puede resolver disputas sobre la «verdad» cuando dependen de interpretaciones subjetivas o valores personales. Además, si la información es demasiado reciente o no está bien documentada, puede carecer de una base suficiente para una verificación completa. Los errores humanos en los datos de entrenamiento también representan un reto, ya que el modelo se alimenta de texto generado por personas, que puede contener errores o sesgos difíciles de filtrar.

Cómo evaluar la confiabilidad de una respuesta generada por IA

Para que los usuarios puedan evaluar la confiabilidad de una respuesta generada por IA, es recomendable:

- Verificar la fuente: Comparar la información con fuentes confiables y verificadas.

- Buscar múltiples referencias: No basarse en una sola respuesta del chatbot, sino contrastarla con otras fuentes.

- Identificar sesgos: Analizar si la respuesta equilibra de manera artificial posturas desiguales en respaldo científico.

- Consultar a expertos: En temas complejos, recurrir a verificadores profesionales o especialistas en la materia.

- Evaluar la claridad y precisión: Respuestas vagas o evasivas pueden indicar limitaciones en los datos de entrenamiento del chatbot.

Cómo usar esta tecnología de forma responsable

Si bien es cierto que este tipo de tecnología no es recomendable para hacer un ejercicio de fact-checking, sí puede ser útil para potenciar tus actividades como:

- Automatización de tareas repetitivas: Los chatbots pueden ayudarte a agilizar tareas rutinarias y repetitivas, como responder preguntas frecuentes o procesar grandes volúmenes de información de manera eficiente.

- Generación de ideas y contenido inicial: Puedes utilizar estos sistemas para generar borradores de contenido, ideas iniciales o planteamientos en los que luego puedas profundizar y verificar. Esto es útil para acelerar el proceso creativo y de redacción.

- Asistencia en la investigación preliminar: Los chatbots pueden ser una herramienta para realizar investigaciones preliminares, ofreciendo una visión general de los temas de interés y proporcionando enlaces a fuentes relevantes, que deben ser verificadas siempre. Por ejemplo: «resume esto», «analiza el argumento» o «busca más info sobre este tema».

- Mejora de la productividad: Si bien no sustituyen el juicio crítico humano, los chatbots pueden optimizar tu flujo de trabajo y facilitar la gestión de proyectos, al organizar información, recordarte plazos importantes o gestionar tareas.

*Parte de este explicativo fue hecho con información de la Agencia de Contenidos de Maldita.es

Fuentes:

Open Ethics

Iris Domínguez

Usuarios Digitales

NewsGuard

Agencia de Contenidos de Maldita.es.