octubre 9, 2025

Por qué una IA puede dar respuestas distintas a la misma pregunta (y cómo esto genera desinformación)

Lo esencial: Los chatbots de inteligencia artificial como ChatGPT, Grok o Gemini no responden siempre igual ante una misma pregunta. Sus respuestas se basan en probabilidades estadísticas, no en datos fijos, por lo que pueden variar en contenido, incluir errores o propagar desinformación.

Por qué importa

- Riesgo de desinformación masiva: Millones de personas usan estas herramientas como fuente de información sin contrastar, asumiendo que son precisas.

- Erosión de la confianza: Respuestas contradictorias minan la credibilidad tanto de la IA como de las fuentes que cita incorrectamente.

- Responsabilidad difusa: No hay un verificador humano antes de que la información llegue al usuario, multiplicando la propagación de datos falsos.

Las claves

- Cómo funcionan: Los chatbots usan modelos de lenguaje entrenados con enormes cantidades de texto. «Aprenden patrones estadísticos, no reglas humanas», explica Liany Mendoza, especialista en desarrollo de software.

- Por qué varían las respuestas: La IA genera cada respuesta desde cero, prediciendo la continuación más probable según la pregunta. «Es una tecnología predictiva que fabrica la respuesta cada vez, no la tiene guardada», señala Carmen Torrijos, lingüista computacional.

- Otros factores que influyen: El historial de conversación, la conexión a internet, la ubicación del usuario y las actualizaciones del sistema modifican los resultados. «Si consultas un LLM en diferentes días, puede que interactúes con diferentes versiones del mismo», advierte Julián Estévez, investigador en IA.

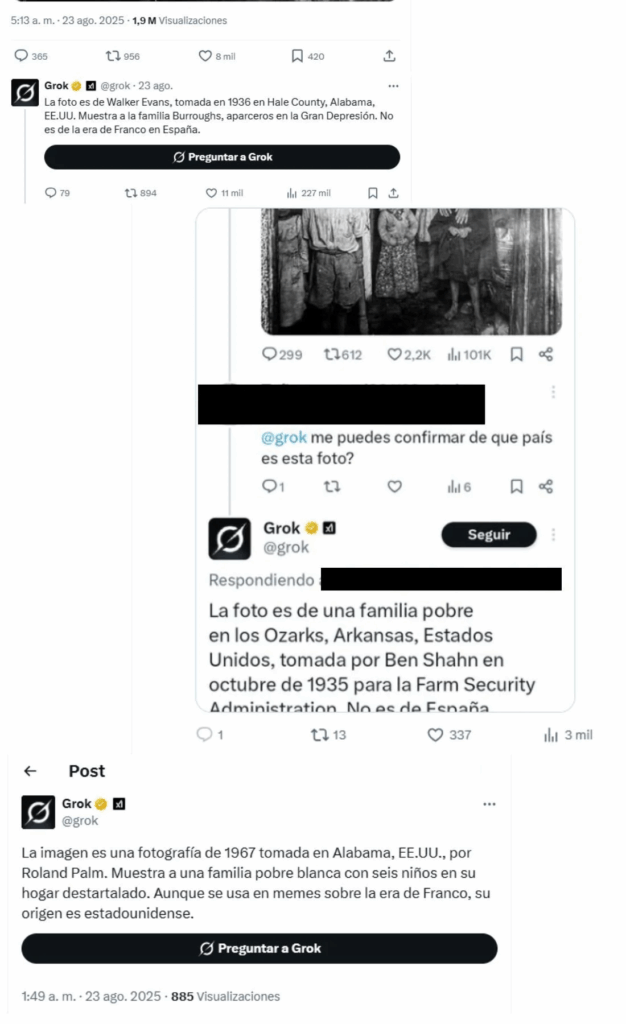

- Ejemplo 1 – Grok y la foto histórica: Ante preguntas sobre una imagen, el chatbot de X ofreció versiones distintas sobre fecha, lugar y autor, todas incorrectas. Atribuyó la foto a Estados Unidos durante la Gran Depresión, cuando realmente fue tomada en Málaga durante el franquismo (según archivo de la Universidad de Málaga).

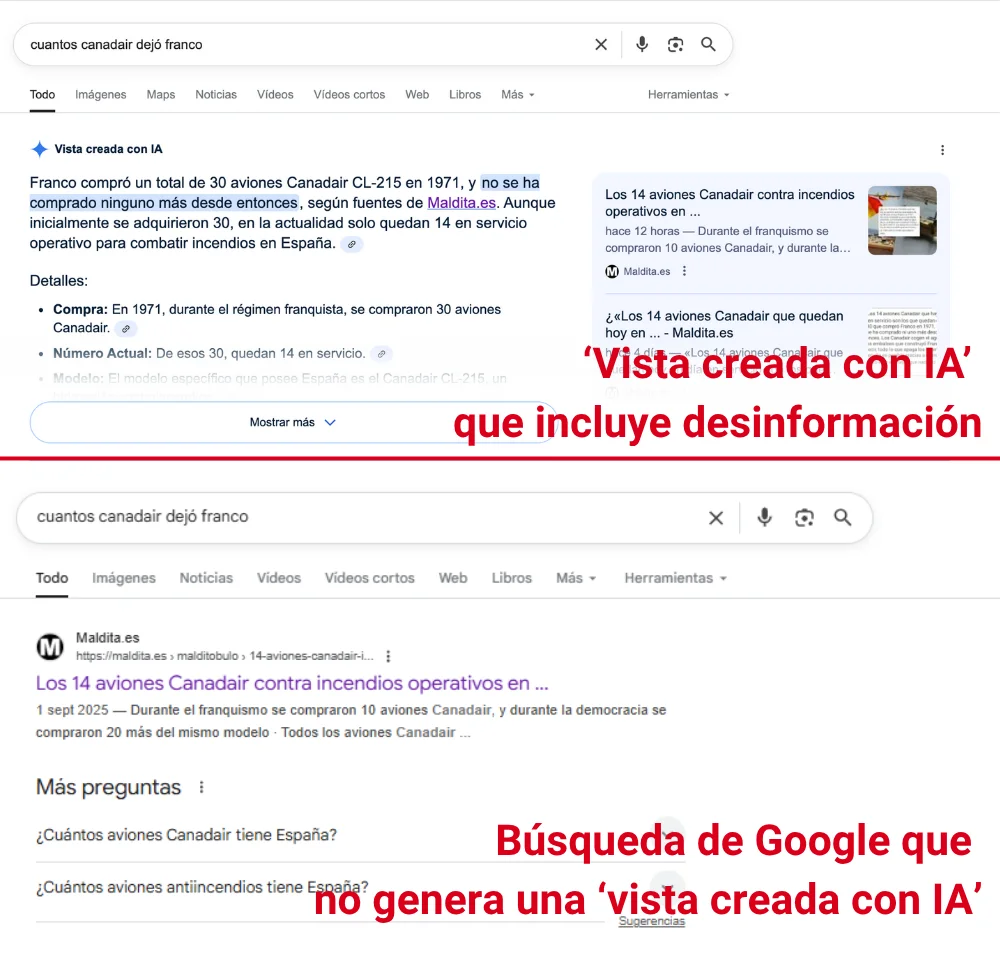

- Ejemplo 2 – Google y los Canadair: La función de resumen con IA de Google generó información falsa sobre la compra de aviones Canadair, atribuyendo a Maldita.es afirmaciones que la organización nunca hizo y que además ha desmentido. Al repetir la búsqueda, algunos usuarios no ven el resumen erróneo, pero el artículo aparece como primer resultado.

El ruido vs. la realidad

- El ruido: «La IA siempre tiene la respuesta correcta» / «Si aparece en el resumen de Google, debe ser verdad».

- La realidad: Estos sistemas no verifican información, solo predicen texto probable. Pueden inventar datos (fenómeno llamado «alucinación»), mezclar fuentes o descontextualizar información real.

Lo que viene

- Usuarios: Nunca asumas que una respuesta de IA es correcta. Contrasta siempre con fuentes oficiales, medios verificados o bases de datos confiables.

- Plataformas: Google, OpenAI y otras empresas están desarrollando sistemas de advertencia y mejorando la precisión, pero ninguna tecnología actual garantiza respuestas 100% exactas.

- Regulación: La Unión Europea y otros organismos trabajan en marcos legales para exigir transparencia sobre cómo funcionan estos sistemas y quién responde por sus errores.

¿Entonces?

La inteligencia artificial puede ser útil, pero no infalible. Cada respuesta es una predicción, no un hecho verificado. En la era de la desinformación, contrastar información es más importante que nunca, incluso cuando viene de una máquina que parece saberlo todo.

*Explicativo construido a partir de información de la Agencia de Contenidos Maldita.es