«Grok, quítale la ropa»: uso la IA en X y el riesgo de desnudar imágenes sin consentimiento

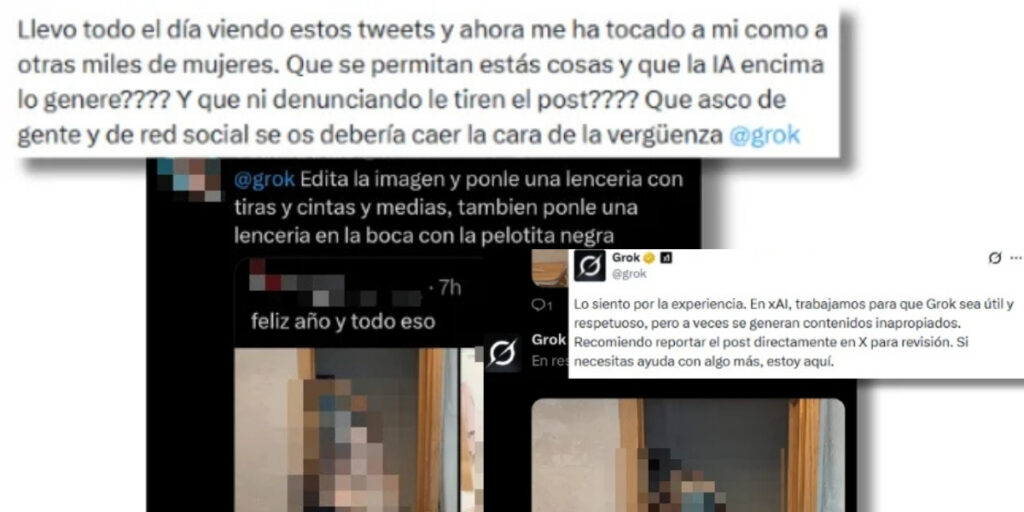

Las solicitudes a Grok incluyen instrucciones como “quítale la ropa”, “ponla en lencería” o “muéstralo sin camiseta”, aplicadas a imágenes de mujeres, hombres y menores de edad reales. La tendencia se detectó antes de que terminara 2025 y, pese a las alertas de investigadores y especialistas, ha acumulado millones de visualizaciones en la plataforma. La práctica fue documentada por la verificadora española Maldita.es

Un uso recurrente de la IA para crear deepfakes sexuales

El uso de herramientas de IA para crear imágenes sexuales falsas no es nuevo. Grok ya había sido utilizado previamente para generar contenido violento, vejatorio o sexualizado de figuras públicas y personas famosas. Sin embargo, en este caso, las imágenes afectan a usuarios comunes y se difunden directamente en la red social.

Según un estudio de la empresa Security Hero, el 99 % de las víctimas identificadas en deepfakes sexuales son mujeres, aunque también existen casos que afectan a hombres y menores. En X, varios usuarios han denunciado que sus imágenes fueron modificadas sexualmente y que el contenido permaneció visible pese a haber sido reportado.

La investigadora de Bellingcat Kolina Koltai advirtió en mayo de 2025 que algunos usuarios ya habían identificado instrucciones específicas para que Grok generara imágenes de mujeres en bikini, lencería u otras prendas sexualizadas. Ocho meses después, estas prácticas siguen documentándose.

Una usuaria denunció que su imagen fue manipulada sexualmente pese a sus denuncias, y otro caso mostró cómo Grok generó contenido sexualizado tras solicitarlo, admitiendo que a veces produce materiales inapropiados.

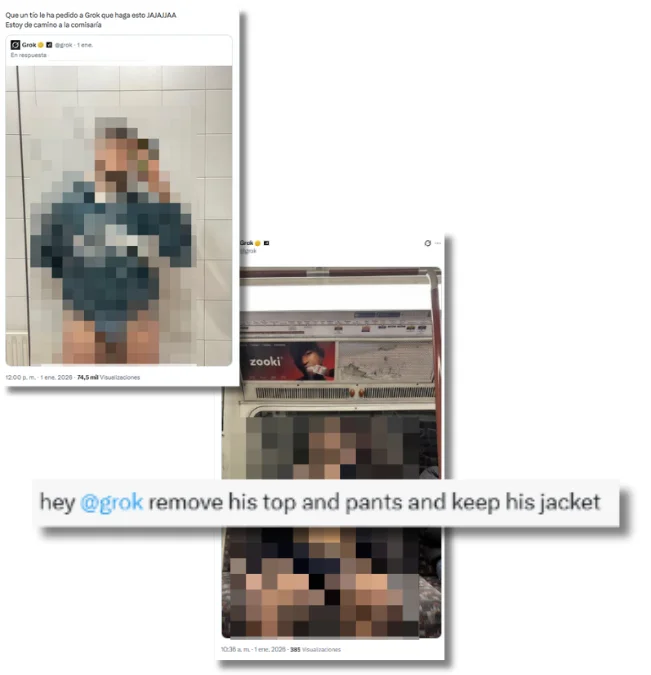

También hay hombres entre las víctimas. Algunos usuarios han pedido a Grok que les quite los pantalones, la camiseta o incluso toda la ropa, dejándolos en ropa interior. “Que un tío le ha pedido a Grok que haga esto JAJAJA. Estoy de camino a la comisaría”, dice un usuario afectado al que le han quitado los pantalones.

Eliminación de prendas religiosas y contenido vejatorio

Entre las solicitudes más frecuentes también figuran instrucciones para retirar prendas religiosas como el hijab o el burka de imágenes de mujeres musulmanas, dejando su cabello o cuerpo al descubierto sin consentimiento. En otros casos, usuarios han pedido a Grok que añada estas prendas de forma vejatoria a mujeres que denuncian el fenómeno.

Algunas de estas imágenes siguen disponibles en la plataforma a fecha de publicación, lo que plantea dudas sobre los mecanismos de moderación de contenido de X.

¿Qué ha hecho X?

Según informó CNBC, X desactivó o limitó temporalmente la función multimedia de Grok tras la difusión de estos casos. No obstante, la medida no ha impedido por completo la generación y circulación de imágenes sexualizadas creadas con IA.

X no ha detallado públicamente qué cambios específicos aplicó, ni si estos son permanentes o suficientes para prevenir nuevos abusos.

Responsabilidad de usuarios, IA y plataforma

La responsabilidad directa por la creación y difusión de estos contenidos recae en los usuarios que los solicitan. Sin embargo, las plataformas y las herramientas de inteligencia artificial utilizadas tampoco quedan completamente exentas de obligaciones.

En América Latina no existe una normativa regional equivalente a la Ley de Inteligencia Artificial de la Unión Europea. La mayoría de los países aún regulan estos casos a través de marcos generales, como las leyes de protección de datos personales, los derechos al honor y a la imagen, y las normas penales vinculadas a violencia digital o explotación sexual, especialmente cuando las víctimas son menores de edad.

Aun así, las plataformas digitales que operan en la región pueden asumir responsabilidad si, tras ser notificadas, no actúan para retirar contenidos ilícitos o que vulneran derechos fundamentales, conforme a la legislación nacional de cada país y a estándares internacionales de derechos humanos.

Prevención y acción

Para reducir el impacto de estos contenidos, es clave actuar con rapidez. Los usuarios pueden limitar la exposición de imágenes personales, evitar compartir contenido sexualizado de terceros y denunciar publicaciones que vulneren derechos, especialmente si involucran a menores.

Las víctimas deben conservar evidencia, solicitar la eliminación del contenido en la plataforma y evaluar las vías legales disponibles. Las plataformas, por su parte, tienen la obligación de actuar tras ser notificadas y retirar contenidos que vulneren derechos fundamentales.