“No son reales, pero las sentimos reales”: La desinformación emocional generada por IA

¿Emblemas de la “realidad”?

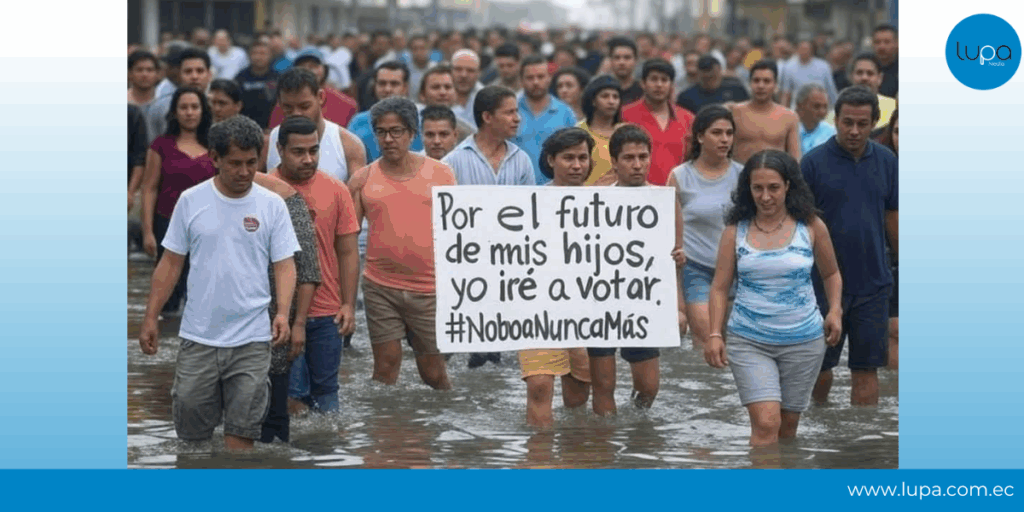

Un retrato impactante de un grupo de personas con expresiones de agotamiento y resignación, caminando con el agua hasta las rodillas, comenzó a circular en medio de las inundaciones en Ecuador, cuando el presidente Daniel Noboa propuso que los afectados por las lluvias no fueran sancionados por no acudir a las urnas. La imagen, de un realismo sorprendente, se viralizó rápidamente sin que se señalara que era un contenido generado por inteligencia artificial.

El 13 de abril de 2025, durante las elecciones presidenciales, la imagen resurgió con un claro mensaje político, acumulando miles de visualizaciones y compartidos en redes sociales. ¿Aunque no se trate de una manipulación, este tipo de contenido puede considerarse desinformación? La imagen no alteró un hecho, pero construyó un escenario emocional que apelaba a la indignación ciudadana, a partir de un evento real. Así, la IA no solo reproduce la realidad: la reinterpreta con intenciones políticas.

¿Por qué compartimos algo que sabemos que no es real?

Mike Wendling, periodista digital de la BBC, explicó a Lupa Media un fenómeno cada vez más común: “La gente sabe que las imágenes no son reales, pero las sienten reales.”

En un informe reciente, BBC Verify, la unidad de verificación de la cadena británica, analizó el caso de una imagen creada con IA de una supuesta víctima de un huracán en EE. UU. A pesar de ser falsa, fue compartida por políticos que aseguraban que representaba el sufrimiento real de los afectados. Es decir, defendieron la imagen no por su veracidad, sino porque ilustraba una “verdad emocional”.

Lo mismo ocurrió en Ecuador: se usó un hecho verdadero (las inundaciones) para proyectar un sentimiento político —en este caso, contra un candidato— mediante una imagen que evocaba una indignación colectiva.

¿Una “verdad superior” justifica compartir imágenes falsas?

Wendling advierte que muchas personas defienden este tipo de imágenes con el argumento de que “expresan una verdad más profunda”. El caso del huracán en EE. UU. lo demuestra: algunos usuarios afirmaban que la imagen servía para denunciar la supuesta indiferencia del gobierno de Joe Biden hacia las comunidades rurales del norte de California.

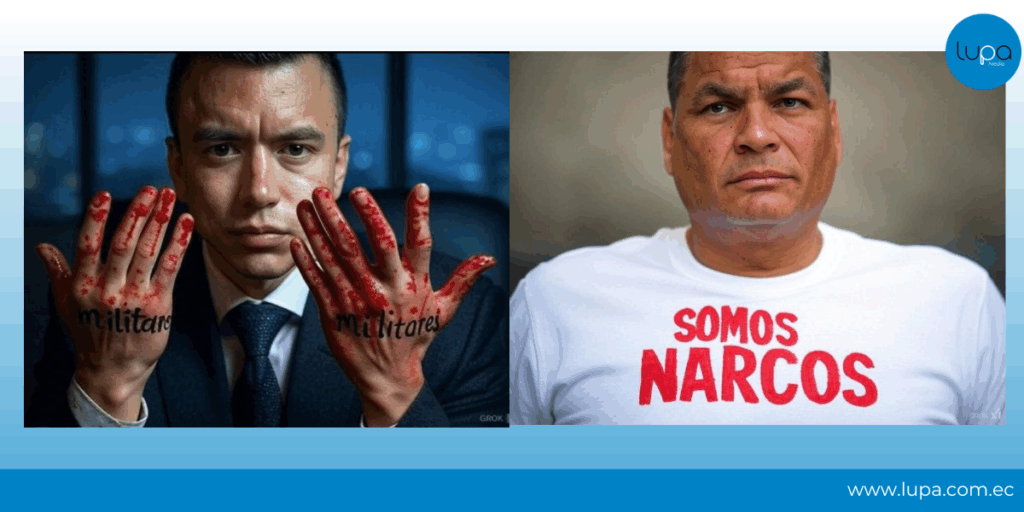

Durante la campaña ecuatoriana, también se compartieron imágenes creadas con IA para acusar a Noboa de indiferencia ante el asesinato de cuatro niños en Las Malvinas, o para insinuar vínculos del correísmo con el narcotráfico. Estas representaciones no se basaban necesariamente en hechos concretos, pero sí apelaban a emociones intensas, reforzando narrativas polarizantes.

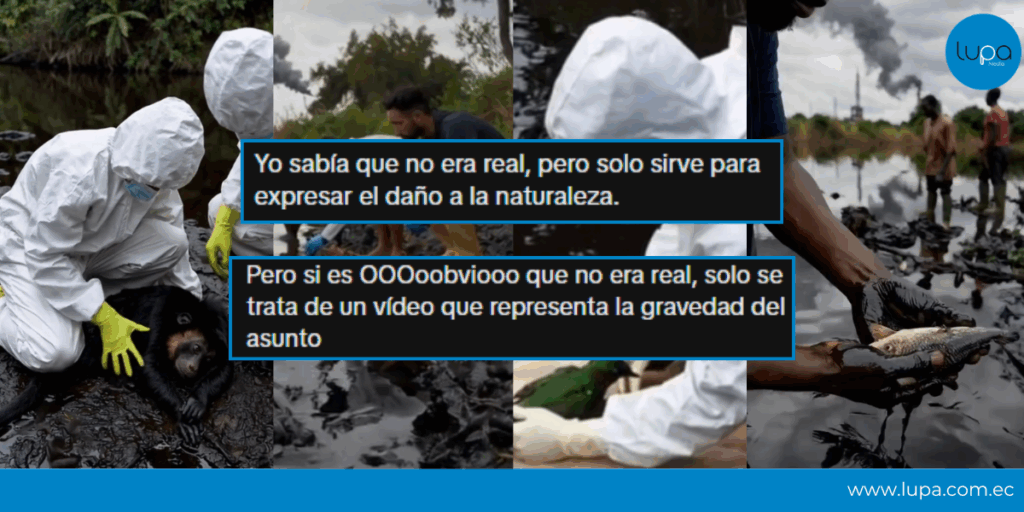

¿Puede una mentira emocional tener más impacto que un dato verificado? Incluso cuando Lupa Media desmintió un video sobre animales afectados por un derrame en Esmeraldas —también generado con IA—, hubo usuarios que defendieron su uso porque “servía para visibilizar” la magnitud del daño ambiental.

Wendling enfatiza que por más que se desacrediten las imágenes falsas no hay manera, de que mediante el fact-checking, se cuestione o investigue “la verdad superior” que la gente atribuye a estas representaciones.

¿Cómo nos engañamos a nosotros mismos al ver una imagen?

Las imágenes hiperrealistas creadas con IA no solo engañan por su aspecto, sino por cómo activan nuestros sesgos cognitivos. Según una consulta a ChatGPT, los más comunes son:

- Sesgo de realidad: lo que parece real, se asume como real.

- Sesgo de confirmación: se acepta solo lo que refuerza nuestras creencias.

- Verdad ilusoria: una imagen repetida se percibe como cierta.

- Efecto halo: si la imagen es atractiva, se vuelve más creíble.

- Sesgo de disponibilidad: lo impactante se recuerda más fácilmente.

- Sesgo de autoridad: si alguien influyente comparte algo, se da por válido.

- Apofenia: tendencia a ver patrones o mensajes donde no los hay.

Creación sin filtros y control

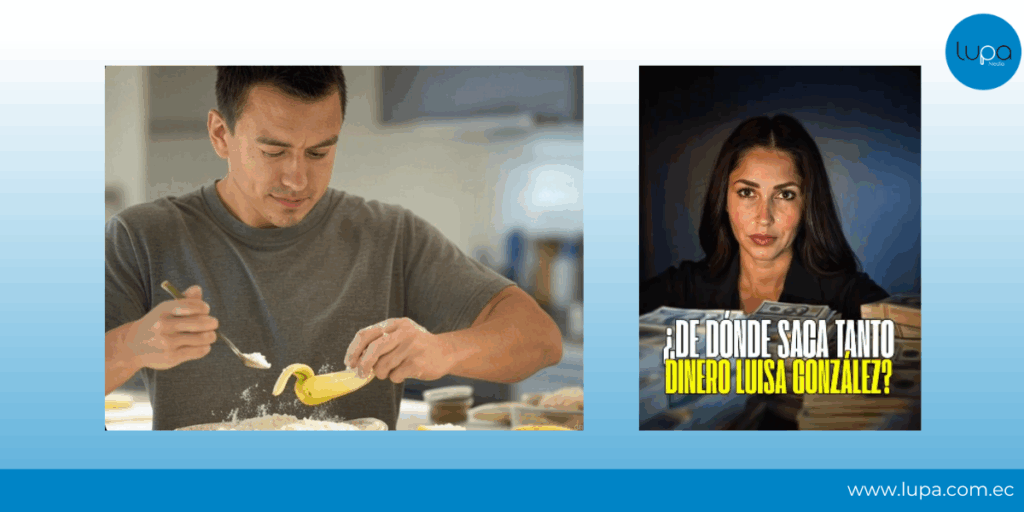

Durante las elecciones en Estados Unidos en 2024, Maldita.es alertó que la IA generativa de Grok funcionaba sin filtros, permitiendo crear imágenes violentas, sexualizadas o que propagaban mentiras. En Ecuador, la situación fue similar: se usaron imágenes para vincular a candidatos con delitos o escándalos, sin pruebas, pero con una estética convincente.

En contraste, otras plataformas imponen restricciones para evitar representaciones políticas engañosas.

La Fundación Gabo advierte que lo que está en juego no es solo la veracidad de una imagen, sino su impacto en la percepción pública. Recomienda informar siempre a la audiencia cuando se use contenido creado o alterado por inteligencia artificial. “Debemos tener en cuenta que una imagen editada, mejorada, matizada por la IA puede llegar a maquillar hechos reales para mostrarlos más allá de lo que en verdad pasó”, indica el Laboratorio Ético de la Fundación.

La IA está de moda y divierte

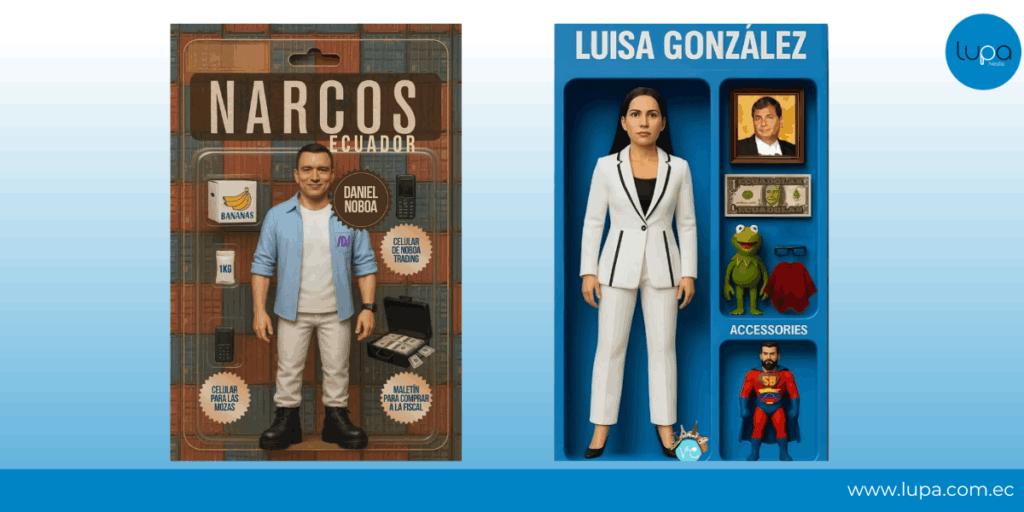

El uso de IA también se mezcló con la cultura pop y el humor. Durante la campaña ecuatoriana, se viralizaron figuras de acción que representaban a los candidatos como si fueran personajes de cómic. Otras imágenes, como la de Luisa González convertida en la Rana René tras los audios del caso “Ligados”, apelaban a la burla y la sátira. Pero aun esos formatos, aparentemente inofensivos, transmitían mensajes políticos, sin necesidad de datos ni argumentos.

Por ahora, el uso político de la IA depende de nuestras propias creencias. Es decir, la tecnología no impone una narrativa, pero sí la amplifica. Los mensajes políticos también están siendo creados y difundidos mediante esta tecnología, apelando a una «verdad emocional» que resulta más persuasiva que los hechos verificables. Por eso es clave entender que los contenidos creados con IA no solo entretienen o ilustran: también pueden desinformar.

Recomendaciones

- Las imágenes generadas con inteligencia artificial deben identificarse claramente como tales.

- Pregúntate: ¿quién creó esta imagen y con qué intención?

- No compartas contenido solo porque te genera emoción. Verifica.

- Los actores políticos deben comprometerse a no usar IA con fines manipulativos.

- Fomentar el pensamiento crítico es clave para no caer en trampas visuales.

Fuentes:

Consulta por correo a Mike Wendling, periodista digital de la BBC.

BBC/ Fotografía falsa de niña en huracán Estados Unidos/ 04-10-2024

Fundación Gabo

Maldita.es

Teleamazonas/ Seudónimos caso «Ligados»