¿Subir datos médicos a ChatGPT o Grok? Expertos recomiendan NO compartir información sensible con chatbots de IA

Este artículo es una adaptación de un contenido publicado originalmente por Maldita.es, actualizado por Lupa Media en enero de 2026.

Cada vez más personas consultan su salud con IA —y eso implica riesgos

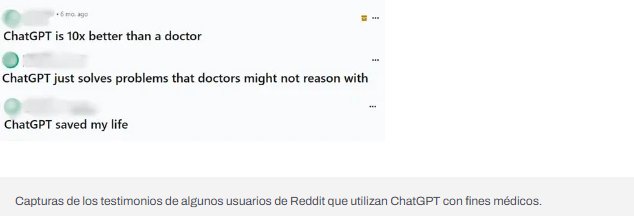

Algunos usuarios están recurriendo a herramientas como ChatGPT o Grok para obtener respuestas rápidas sobre temas médicos, incluso subiendo radiografías, resultados de laboratorio o diagnósticos clínicos.

En enero de 2026, OpenAI lanzó ChatGPT Health, una función experimental para consultas relacionadas con la salud. Además, Elon Musk ha promovido el uso de Grok para obtener diagnósticos médicos.

El problema es que los chatbots no sustituyen a un profesional de la salud y pueden generar respuestas inexactas o engañosas. La Agencia Española de Protección de Datos advierte que estos sistemas pueden producir desinformación o inducir al error, con posibles consecuencias para la salud física y emocional de las personas.

Los datos médicos son altamente sensibles (y compartirlos implica perder control)

Los datos sanitarios —como diagnósticos, historiales clínicos, pruebas médicas o imágenes— son considerados información especialmente protegida por el Reglamento General de Protección de Datos (RGPD).

Expertos en ciberseguridad y protección de datos advierten que:

- Compartir documentos médicos con un chatbot implica perder control sobre esa información.

- Las empresas pueden usar esos datos para entrenar o mejorar sus modelos.

- Si ocurre un ciberataque o una filtración, la información podría quedar expuesta públicamente.

- En compañías con sede fuera de la Unión Europea, las garantías legales pueden ser más limitadas.

“Cuando compartimos un documento con un chatbot de IA, perdemos automáticamente el control de esa información”, explica a Maldita.es Samuel Parra, abogado especializado en protección de datos.

¿Pueden las IAs usar estos datos para entrenarse?

Tanto ChatGPT como Grok indican en sus políticas que el contenido de los usuarios puede utilizarse para mejorar sus servicios.

Aunque OpenAI asegura que las conversaciones en ChatGPT Health no se usan para entrenar los modelos principales, no detalla completamente cómo se gestionan estos datos.

Otro riesgo es que no siempre está claro cuánto tiempo se almacenan los documentos ni con qué fines futuros pueden utilizarse.

No hay trucos infalibles: modo incógnito, chats temporales o anonimizar no garantizan protección

Algunas personas intentan reducir riesgos usando:

- Navegación en incógnito

- Chats temporales

- Eliminación de conversaciones

- Anonimización de documentos

Sin embargo, los expertos coinciden en que ninguna de estas medidas garantiza que los datos no se almacenen, reutilicen o reconstruyan.

Incluso la anonimización puede fallar, ya que una IA puede detectar patrones y reidentificar información indirectamente.

¿Es legal que una IA procese datos médicos?

La normativa europea obliga a los sistemas de inteligencia artificial a:

- Limitar el uso de datos sensibles

- Aplicar medidas estrictas de protección de la privacidad

- Evitar la reutilización o transferencia indebida de información sanitaria

Además, la Ley Europea de Inteligencia Artificial prevé clasificar ciertos modelos como de alto riesgo, especialmente si pueden afectar la salud y la seguridad pública, lo que implicará obligaciones adicionales de protección.

¿Qué pasa si ya compartiste datos médicos con una IA?

Las opciones existen, pero son limitadas.

Las personas pueden ejercer su derecho a la supresión de datos (artículo 17 del RGPD) para solicitar la eliminación de su información sanitaria.

Sin embargo:

- No siempre es posible comprobar si los datos fueron realmente eliminados.

- En los sistemas de IA, la información puede quedar integrada en el entrenamiento del modelo, lo que dificulta su borrado total.

Recomendación clave

Lo más seguro es NO subir datos médicos ni información sensible a ningún chatbot de IA.

Si decides usar estas herramientas:

- No compartas exámenes médicos ni diagnósticos

- No subas documentos clínicos

- No reveles información personal o de terceros

- Usa la IA solo como referencia general, nunca como sustituto de atención médica profesional

¿Entonces?

La inteligencia artificial puede ser una herramienta útil, pero no debe reemplazar la atención médica ni poner en riesgo nuestra privacidad. Cuando se trata de salud, la información sensible merece el máximo nivel de protección, criterio y responsabilidad.